砺剑出鞘:我的软件工程师求职之旅

本文最后更新于:2 个月前

写在前面

2024 年 3 月 7 日

三月份了,春招在即,我也开始着手准备今年下半年的秋招了。

现阶段的目标是能在短期内找到一份日常实习,再持续投递中大厂的暑期实习岗位。

这注定是一场持久战,从现阶段开始到接下来的九个月里,我不能有丝毫懈怠。

那么,简单记录下我的求职经历吧!

正文

求职经历

2 月 19 日,了解计算机四级网络工程师考点考纲,基本完成项目网站首页,记忆 MySQL 相关八股文,计划开始优化简历。

大三下还打算窝在学校上课,是等着毕业就失业吗?

2 月 20 日,系统分析项目核心功能,优化简历“专业技能”一栏,现阶段第一版简历完成,目标更加清晰;巩固 Spring 相关八股文。

2 月 21 日,着手梳理 Memory API 忆汇廊核心功能;想家了,有感而发,写点生活感悟。

2 月 22 日,着手配置 Canal 监听 MySQL 数据库流水;巩固蓝桥杯考点考纲,了解蓝桥杯算法,做好备考;持续完善项目文档以及 Gitee / GitHub 仓库介绍。

2 月 23 日,记忆 Java、JVM 相关八股文;下午跟小穆聊天,唠家常,唠理想;梳理项目核心功能;尝试 Spring Cloud Gateway 限流。

晚风几许撩人意,夕阳半刻醉人心

2 月 24 日,完善项目架构设计,思考项目优化点和扩展点;梳理项目核心功能,持续优化项目文档以及 Gitee / GitHub 仓库介绍;掘金学习热榜文章:自定义 Starter、MySQL 日志、事务相关知识;计划开始持续输出文章,记录生活;晚点时候,拿到电信流量卡并成功激活。

强者,从来不会抱怨环境。我他妈就是强者

2 月 25 日,简单的早间点滴;第一次来餐厅自习;完善计算机网络八股,开始阅读《HTTP 四十讲》;着手购买充电宝、便携式桌椅,为面试做准备。

没有什么光阴真正被虚度,也没有任何事情是徒劳无功的

2 月 26 日,在牛客、BOSS、实习僧等了解行情;持续学习计算机网络;基本完成项目文档编写,完善 SDK Gitee 项目介绍;阅读《孙子兵法》《朝花夕拾》。

知识改变年薪,文化改变命运

2 月 27 日,六级三战失败,血压暂时升高;优化简历“专业技能”一栏,添加设计模式、个人优势等内容;一次性完善“项目经历”一栏内容,简历第二版优化完成;持续巩固计算机网络和 Redsi;过牛客链表算法题;计划明天彻底完善简历,打点校园内的面试环境。

截至二零二四年二月二十七日,下午四时四十五分,我的个人博客共有七十余篇博文,总计九百余张图片、五十余万文字

2 月 28 日,快速记忆 Java 基础、Spring 常考面试题;完善实习僧平台信息;基本完善项目文档,优化简历;成功投递第一波简历。

2 月 29 日,持续巩固学习 MySQL、Redis、并发编程、集合等八股;持续投递本地日常实习;沟通几十个、简历几份,到目前为止还没有回应;学习 RPC、网关等微服务架构知识,系统梳理。

3 月 1 日,远程帮助小伙伴完善项目,持续学习微服务架构;终于有人要我简历了,很期待;桌子,椅子,超大容量充电宝都回来了;写点故事;

3 月 2 日,跑步半小时,连续三天在 BOSS 打招呼,计划找个本地实习,但基本已读不回;做京东笔试题;学习链表算法题;头疼,下午补觉;植物大战僵尸汉化版,休息。

3 月 3 日, BOSS 求职回复寥寥无几,心情越发浮躁;晚上读书,计划明天投递第四波简历。

3 月 4 日,学习 Java 并发编程,学习记录 JVM;谈谈我对微服务架构的理解;下午实习僧一键投递,很快啊,投了五十多份简历;实习僧收到一份七号中午的笔试邀请。

3 月 5 日,继续学习 JVM;前两次要简历的都抱歉了;BOSS 有回复,要求 Java 实习转 GO,无薪资,没有后续;学习 Maven 项目管理工具;计划明天开始投递中大厂,基本放弃本地实习机会。

xxxxxxxxxx npm list -g –depth 0 查看全局安装过的模块 npm init 生成 package.json 文件(需要手动选择配置)npm init -y 生成 package.json 文件(使用默认配置)npm i/install 一键安装 package.json 下的依赖包 npm i xxx 在项目中安装包名为 xxx 的依赖包(配置在 dependencies 下)npm i xxx –save 在项目中安装包名为 xxx 的依赖包(配置在 dependencies 下)npm install xxx@latest 更新包的版本至最新 npm i xxx –save-dev 在项目中安装包名为 xxx 的依赖包(配置在 devDependencies 下)npm i -g xxx 全局安装包名为 xxx 的依 2 赖包 npm update -g xxx 更新全局安装的包 npm uninstall -g xxx 卸载全局安装的包 npm run xxx 运行 package.json 中 scripts 下的命令 npm home xxx 打开 xxx 包的主页 npm repo xxx 打开 xxx 包的代码仓库 npm publish 将当前模块发布到 npmjs.com,需要先登录 bash

3 月 7 日,计划投递腾讯实习岗位,完善作品集;开设新博文,记录我的求职经历;完成始祖象的笔试;完成携程招聘笔试题,笔试题还挺有意思;同尹老师交流,介绍了个学长,下午吃饭前给学长投了份简历;中午投递 BOSS,约了下周一的线下面试;学习计算机网络。

3 月 8 日,写日记,好久没写日记了;上午尝试投递 BOSS,又有位 BOSS 肯理我了,现在还没有实习岗位,把我简历要过去了。一周之内如果有实习岗位,就会有答复;下午四点腾讯会议面试,第一次面试,时长三十五分钟,问得比较简单,就是没啥经验,话到嘴边表达不清楚的感觉,还得继续努力呵;始祖象算法工程师岗位又发来笔试邀请了,15 号的笔试;根据京东大佬指点意见,优化简历。

3 月 9 日,面向面经复习;简历优化,内容更加精炼;写会儿大学故事;在安居乐租房软件上了解租房动态,上 B 站了解租房注意事项;下午继续 BOSS 投递,又成功投出去一份简历;跟小穆聊天,分享求职进展;晚上面向面经,查缺补漏。

3 月 10 日,跑步,半小时;备考计算机四级网络工程师,找到完备题库,计算机四级稳了;面向面经复习;调试鱼聪明,竟然还要再充会员嘛;中午投递一波简历,又有一份回应;性能优化,Spring Boot 自动装配原理;豚鼠系列《下水道的美人鱼》;回忆大学中的每个假期;API 项目介绍,看相关面经。

3 月 11 日,投递简历,BOSS 询问进展状况;询问学长进展状况;投递各大官网;做腾讯、快手测评;洛阳寰宇网阔科技公司,人事刘先生,态度蛮不错的。事事有回音,不招在校生,还祝我前程似锦。跟导员沟通离校实习,她说不行。。果然导员没啥用。。投递百度实习生岗位;续写《该死的万柏林区》;看《雪山迷踪》;找回状态,高效巩固复习。

3 月 12 日,更新 BOSS 招呼语;跑步半小时;巩固线程池,ThreadLocal,Redis;持续投递 BOSS 平台;面经是永远背不完的!自备战日常实习以来,直到今晚我才能彻底理解这句话;了解学习 Docker 部署。

3 月 13 日,蓝桥杯真题是真看不懂,这跟代码有什么关系,全是数学题。。持续投递 BOSS 平台,太原附近完全没有实习生招生计划吗?系统学习 Elasticsearch 实现原理;拿到蓝桥杯的相关备考资料;牛客网投递了一波暑期实习招聘:五八同城、OPPO、阿里;一周前实习僧海投的岗位回应我了,上海,无兴趣;《地球脉动》。

3 月 14 日,跟太原本地初创公司交流;约了明天和后天的两个面试;再次迭代简历,添加中间件掌握情况;最后一次全面巩固复习面经,为明天的面试做准备。

自八月初优化好最新一版简历后,开始陆陆续续投递。

实训生活第三周,8 月 20 日,从上周周五即 8 月 16 日开始,每天坚持投递简历。

投递

2024 年 8 月 20 日

每次投递简历,总要一遍遍复制粘贴我的项目和实习经历介绍,真是太麻烦了,我直接粘贴在这里:

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

9 月 6 号,苏州大宇宙面试通过,通知随去时实习,暂不考虑;晚做挚友笔试;优化新版简历。

南京

2025 年 2 月 19 日

已经结束了。

还有三个月左右的时间。

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

权且当作是黄粱一梦。

继续生活。

2025 年 2 月 21 日

我希望只是预热,最好不要让我面临这样的结果。

| 项目列表 |

|---|

| 调度运行指挥自主巡航(DCS) |

| 中核运维合同项目 |

| 中卫大数据 |

| 合江智能辅控综合监控主站 |

| 华电竞争报价系统项目 |

| 金风三峡智能运检系统 |

| 山东智能巡检 |

| 新疆苇湖梁场站智能巡检系统 |

| 广东电网 2025 年大运会智慧保电指挥系统 |

| 智能操作票(DCCS) |

2025 年 2 月 24 日

周末已经过去了,还没想好后路。

2025 年 4 月 9 日

开发经验,网络协议,Nginx,JVM,AI

1 | |

2025 年 4 月 22 日

1 | |

2025 年 8 月 20 日

Spring Security,Sa-Token,JWT,Mybatis,Nginx,Websocket(即时通讯,实时更新,在线游戏,协同编辑),SSE(了解)。

Caffeine 本地缓存,Redis 分布式缓存,ShardingSphere 分库分表(了解),RabbitMQ。

2025 年 8 月 21 日

springboot3整合SpringSecurity实现登录校验与权限认证(万字超详细讲解)_springboot security-CSDN博客

mybatis看这一篇就够了,简单全面一发入魂_mybatis一发入魂-CSDN博客

Mybatis Plus 看这篇就够了,通俗易懂,一发入魂_com.baomidou.mybatisplus.core.mybatismapperannotat-CSDN博客

[Spring Boot 实战开发](https://learn.lianglianglee.com/专栏/Spring Boot 实战开发)

2025 年 8 月 29 日

问题1:在MryAPI开放平台项目中,你提到使用了Spring Cloud Gateway进行流量染色,请详细描述一下流量染色的具体应用场景以及你是如何实现的?

面试思路:考察候选人对流量染色技术的理解和实际应用能力。流量染色在灰度发布、AB测试等场景中非常重要,通过这个问题可以评估候选人是否真正掌握了这项技术,并能将其应用到实际项目中。

面试话术:在MryAPI开放平台中,我们主要使用流量染色来实现灰度发布。例如,当我们上线一个新版本的接口时,我们不希望所有用户都立即访问到新版本,而是希望先让一部分用户(例如内部测试用户或特定地区的少量用户)先体验新版本,观察是否有问题。通过流量染色,我们可以给这部分用户的请求打上特定的标记(例如header中添加一个特定的key-value),然后在Gateway中配置路由规则,将带有这个标记的请求转发到新版本的接口服务,而其他用户的请求仍然转发到旧版本的接口服务。具体实现上,我们使用了Gateway的Predicate和Filter机制,自定义了Predicate来匹配带有特定标记的请求,然后使用Filter来修改路由规则,将请求转发到指定的upstream。这样,我们就可以实现对特定流量的精确控制,从而实现平滑的灰度发布。

问题2:你提到为防止接口被恶意调用,设计了API签名认证算法,并为用户分配了唯一的ak/sk进行鉴权。请详细描述一下你的API签名认证算法的具体流程,以及你是如何保证ak/sk的安全性的?

面试思路:考察候选人在API安全方面的知识和实践经验。API签名认证是保障接口安全的重要手段,通过这个问题可以评估候选人是否了解常见的签名算法,以及如何防止ak/sk泄露和被滥用。

面试话术:我们的API签名认证算法流程如下:首先,客户端在发起API请求时,需要将请求参数按照一定的规则进行排序(例如按照参数名的字典序),然后将排序后的参数和请求体拼接成一个字符串。接着,使用HMAC-SHA256算法,以用户的sk作为密钥,对拼接后的字符串进行加密,生成签名。最后,将ak、签名和时间戳等信息放在请求头中发送给服务端。服务端收到请求后,首先根据ak找到对应的sk,然后使用相同的算法对请求参数进行签名,并与客户端传递过来的签名进行比对。如果签名一致,则认为请求是合法的。为了保证ak/sk的安全性,我们采取了以下措施:1. sk只在用户创建时显示一次,之后不再明文存储,而是存储其哈希值。2. 在数据库中对ak/sk进行加密存储。3. 限制ak/sk的使用频率,防止暴力破解。4. 定期轮换ak/sk。5. 监控API调用日志,及时发现异常请求。

问题3:你提到使用OpenFeign抽取优化公共服务,实现了网关模块轻量化和服务解耦。请详细描述一下你具体抽取了哪些公共服务?以及在抽取过程中遇到了哪些挑战,你是如何解决的?

面试思路:考察候选人对微服务架构的理解和实践能力,以及解决问题的能力。通过这个问题可以评估候选人是否能够合理地进行服务拆分和解耦,并能够应对抽取过程中可能遇到的各种问题。

面试话术:我们主要抽取了以下公共服务:1. 接口校验服务:负责对请求参数进行校验,例如校验参数类型、长度、格式等。2. 用户鉴权服务:负责验证用户的身份和权限,判断用户是否有权限调用该接口。3. 流量统计服务:负责统计接口的调用次数、响应时间等指标。在抽取过程中,我们主要遇到了以下挑战:1. 如何保证抽取后的服务性能:由于抽取后的服务需要通过网络调用,因此会增加额外的延迟。为了解决这个问题,我们使用了缓存技术,将一些常用的数据缓存在本地,减少对远程服务的调用。2. 如何保证数据的一致性:由于抽取后的服务涉及到多个服务之间的数据交互,因此需要保证数据的一致性。为了解决这个问题,我们使用了分布式事务,保证在多个服务之间的数据操作要么全部成功,要么全部失败。3. 如何处理服务之间的依赖关系:由于抽取后的服务之间存在依赖关系,因此需要合理地管理这些依赖关系。为了解决这个问题,我们使用了服务注册与发现机制,让服务能够动态地发现和调用其他服务。

对照

2025 年 9 月 1 日

你是如何基于 BitMap 实现用户年度刷题记录统计的?又如何进一步优化该接口性能? - 面试鸭 - 程序员求职面试刷题神器

招呼语

2025 年 4 月 21 日

1 | |

1 | |

1 | |

1 | |

2025 年 7 月 29 日

跨域。

解决跨域问题的本质,是往响应头里塞几个字段,即:

1 | |

因此,只要能够改写响应头的地方都可以解决跨域问题,所以市面上才会出现那么多解决跨域的方式:

- 使用

@CrossOrigin注解解决跨域问题; - 实现

WebMvcConfigurer接口解决跨域问题; - 通过自定义

Filter过滤器解决跨域问题; - 通过

Response对象实现跨域问题; - 通过实现

ResponseBodyAdvice接口解决跨域问题; - 通过设置Nginx配置解决跨域问题;

- ……

这么多种跨域解决方案听起来很唬人,但只要是服务端解决的跨域问题,殊途同归都是改写响应头罢了。

接口安全性设计。

(十二)漫谈分布式之接口设计上篇:写出一个优秀的接口我们需要考虑什么?作为一名后端开发,你会写接口吗?有人说你这不废话吗 - 掘金

2025 年 9 月 2 日

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

1 | |

南京泰豪

2025 年 9 月 14 日

当然,这是一个非常详细的、基于你项目经验的“参考答案库”。你可以根据自己的实际理解进行微调,使其成为你自己的答案。

一、 关于“软件许可证管理系统”的回答思路

1. 基础原理

Q: 简单讲一下TrueLicense的工作原理和流程?

A: TrueLicense是一个基于非对称加密和数字签名的库。它的核心流程分为三部分:

- 生成证书(服务端):我们使用

keytool生成一对非对称加密的密钥对(私钥和公钥)。私钥由我们公司严格保密,用于签发许可证。当客户购买产品后,我们系统会调用私钥,将客户信息(如有效期、授权数量、绑定的硬件指纹)打包成一个License文件,并用私钥对其进行数字签名,防止篡改。 - 安装证书(客户端):客户将收到的License文件放置在程序指定目录下。我们的客户端应用启动时,会加载这个文件。

- 验证证书(客户端):客户端程序内置了对应的公钥。它会用这个公钥去验证License文件的数字签名。如果验证通过,说明这个文件确实是我们公司签发的,且未被篡改。然后程序再读取其中的授权信息(如有效期、硬件指纹)进行校验,全部通过后,软件才正常功能。

Q: 为什么选择TrueLicense?和其他开源许可库相比有什么优劣?

A: 当时技术选型时主要考察了TrueLicense和License3j。

- 选择TrueLicense的主要原因是它的生态更成熟,资料相对较多,基于Java标准库的

keytool和密码学体系,稳定可靠。 - TrueLicense的优势在于设计清晰,与Java生态集成度深,功能完善(如证书撤销列表CRL)。

- 它的劣势是配置起来稍显复杂,需要自己处理很多细节。而License3j可能更轻量,但当时评估后认为TrueLicense的功能更满足我们商业级的需求。

Q: 证书里通常包含哪些信息?

A: 除了TrueLicense自带的基本信息(如生效日期、过期日期、被授权人),我们还自定义了一些对我们业务至关重要的信息:

- 功能模块列表:允许客户使用哪些高级功能。

- 最大点数/用户数限制:例如,限制同时在线用户数。

- 唯一的硬件指纹:这是由客户端采集客户服务器的CPU、主板、硬盘等硬件信息生成的一个唯一ID,是防止许可证在不同机器间转移的关键。

2. 安全与设计

Q: “绑定设备硬件”具体是怎么实现的?采集了哪些硬件信息?

A: 我们在客户端使用了一个叫oshi-core的开源库来安全地采集硬件信息。

- 采集的信息:我们主要采集了CPU序列号、主板序列号和主硬盘的序列号。这些信息在单台服务器上具有很高的稳定性。

- 生成指纹:并不是直接使用原始序列号,而是将这些信息拼接后,进行一次MD5或SHA256哈希,生成一个唯一的、不可逆的指纹字符串。这样做既保证了唯一性,也避免暴露客户硬件的原始信息。

Q: 如何防止用户伪造这些硬件信息?

A: 这是一个攻防战,我们做了多层防护:

- 环境变量存储:如简历所说,我们将验证服务器地址等信息保存在容器环境变量中,而不是配置文件里,增加定位和篡改的难度。

- 指纹可靠性:优先选用那些在虚拟化环境中难以修改或修改会导致系统不稳定的信息(如主板序列号)。

- 校验逻辑混淆:将证书验证的代码进行一定程度的混淆和加固,增加破解者逆向分析的难度。

- 服务器端记录:每次验证请求(尤其是证书安装时)我们服务端会记录IP、硬件指纹等信息。如果发现同一个许可证对应的指纹频繁变化,会触发风控警报,人工介入调查。绝对的安全不存在,但我们的目标是大大提高伪造的成本和风险。

Q: 客户端是如何“定期校验”证书有效性的?

A: 我们采用了一种启动时全量校验 + 运行中间隔定时校验的策略。

- 客户端应用每次启动时,都会进行一次完整的证书验证(签名、有效期、硬件绑定)。

- 启动后,我们启动一个后台的定时任务(Scheduler),例如每24小时执行一次。它会再次检查证书是否即将过期(如提前7天告警)或是否已被服务器端撤销。

- 定时任务会异步地、安静地去我们的许可证服务器查询一个撤销列表(CRL),不会影响用户正常使用。

Q: 证书被撤销后,客户端是如何感知的?

A: 我们采用的是客户端主动查询的机制,因为软件可能部署在内网,服务端无法主动推送。

- 在之前提到的“定期校验”中,定时任务会携带一个凭证,去查询服务端的一个API接口(例如

/api/license/check-revoked)。 - 服务端维护着一个“证书撤销列表”。如果该证书已被列入黑名单,接口会返回一个特定的状态码。

- 客户端收到响应后,就知道证书已失效,会触发过期处理流程,例如弹出警告并限制软件功能。

3. 异常与处理

Q: 如果客户端无法连接到验证服务器,如何处理?

A: 这是关键的设计点,必须保证客户在网络隔离的情况下也能正常使用。

我们设定了优雅降级策略:

- 首次安装:必须能连通服务器,否则无法完成安装激活。

- 定期校验时断网:如果定时任务连接服务器失败,不会立即使证书失效。我们会允许软件继续正常运行,并在日志中记录网络异常。下次校验成功后再同步状态。

- 核心是“信任但验证”:我们相信本地证书的有效性,定期校验只是一个附加的安全措施和对服务器状态的同步。这保证了软件的可用性。

Q: 证书过期后,“自动处理过期状态”具体是怎么做的?

A: 我们会分阶段处理:

- 预警期:在到期前7天,每次启动软件会在日志和控制台提示“许可证即将过期,请续订”。

- 过期后: 软过期:过期后的第一天,软件功能可能不受影响,但每次启动都会弹出强提醒窗口。 硬过期:过期超过一定天数(如3天)后,软件会降级到免费版模式,限制部分高级功能,但保证核心功能可用,给客户一个缓冲时间去处理续费,而不是直接程序崩溃,体验更好。

二、 关于“部署与工程化”的回答思路

Q: 详细讲一下你的“一键远程部署”脚本是如何工作的?

A: 其实这是一个简化版的CI/CD流程,核心是一个Shell脚本。

- 本地构建:在IDEA中执行Maven命令,完成编译、打包,生成一个Docker镜像并打上标签(

myapp:latest)。 - 一键触发:我编写了一个Shell脚本(

deploy.sh)。我在IDEA中点击运行这个脚本,它会:

a. 通过SSH连接到远端的测试/生产服务器。

b. 执行远程命令:docker stop old-container && docker rm old-container(停止并移除旧的容器)。

c. 执行远程命令:docker pull myapp:latest(拉取我刚构建好的最新镜像)。

d. 执行远程命令:docker run -d --name myapp -p 8080:8080 -e LICENSE_SERVER_URL=... ... myapp:latest(以守护进程模式运行新容器,并注入环境变量)。

e. 整个过程通过SSH一次完成,实现了从本地代码到远程服务的快速更新。

Q: Dockerfile里写了哪些关键内容?

A: 我们采用了多阶段构建来优化镜像。

1 | |

Q: 如何强制 @ApiParam(required=true) 生效?

A: 光有Swagger注解是不够的,我们将其与强大的后端校验结合:

- 在Controller参数上,我们使用Spring的

@Validated注解来启用校验。 - 在DTO字段上,我们使用

@NotBlank、@NotNull、@Size等JSR 303标准注解。 - 全局异常处理:我们有一个

@ControllerAdvice来捕获MethodArgumentNotValidException异常,然后将其转换为简历中提到的标准化错误响应体({code: 10001, message: "用户名不能为空", data: null})。

这样,@ApiParam(required=true)主要给前端看,生成文档;而@NotBlank是后端真正的守护者。两者结合,确保了可靠性。

三、 项目宏观与软技能问题

Q: 这个项目中你遇到的最大技术挑战是什么?

A: 最大的挑战是设计一个兼具安全性和用户体验的许可证验证机制。

- 安全性与可用性的平衡:如果验证太频繁、太严格,可能会误伤正常客户;如果太宽松,又起不到防盗版作用。例如,如何处理“服务器网络隔离”的情况就是一个难题。

- 我的解决方案:我调研了多种方案,最终采用了“启动强校验 + 定时弱校验”的策略,并设计了离线宽限期。同时,通过硬件绑定和代码混淆来提升破解门槛。这个方案在评审时得到了团队的认可,上线后也未收到因此导致的客户投诉。

Q: 你在其中扮演了什么角色?

A: 我是这个许可证子项目的核心负责人。从技术选型(调研TrueLicense)、方案设计(与项目经理讨论授权规则)、后端API开发、客户端验证模块封装,到最后的部署和文档编写,都是由我主导完成的。期间也和前端同事协作,定义了授权状态码和错误提示信息的规范。

Q: 为什么联调成本会那么高?

A: 之前团队没有统一的规范。主要的痛点有:

- 接口契约不清晰:前端认为某个参数可选,后端认为必选,导致频繁调试和修改。

- 错误信息不明确:后端返回晦涩的异常栈信息,前端无法直接展示给用户,需要来回沟通排查。

- 响应格式不统一:有的接口成功返回对象,有的返回

{success: true, data: {...}},失败时格式更是五花八门,前端需要为每个接口写不同的处理逻辑。

Q: 这个许可证系统上线后效果如何?

A: 由于我离职时系统刚上线不久,长期的盗版率数据我还无法获取。但能衡量的直接效果非常显著:

- 部署效率:如简历所说,提升了60%。

- 联调效率:联调周期从3天缩短至1.5天。

- 客户反馈:实施团队的反馈是,许可证的安装和激活流程变得标准化了,他们只需要给客户一个文档即可,咨询类的问题变少了。

- 商业准备:为产品未来实行按年订阅付费(SaaS化)打下了坚实的技术基础,这是最重要的长期价值。

希望这些详细的回答能帮助你更好地准备面试。请务必结合你自己的实际经验来理解和调整这些答案,做到心中有数,对答如流。祝你成功!

好的,我们来深入详细地说明这两个要点。这在面试中是非常好的展示你技术深度和业务理解能力的机会。

一、 功能模块列表 (Feature Flags / Licensing)

这是一个将技术实现与商业策略直接挂钩的典型例子,是许可证系统的核心价值所在。

1. 是什么?

“功能模块列表”是指在生成的许可证文件中,不仅仅包含有效期,还包含一个明确的、加密的授权功能清单。这相当于一个功能开关(Feature Flags)的白名单或权限矩阵。

2. 为什么需要它?

- 差异化定价与销售:允许公司销售不同版本的软件(如:基础版、专业版、企业版),每个版本包含的功能不同,价格也不同。

- 增值服务(Up-sell):客户可以先购买基础版,后续再付费解锁某个高级模块(如数据分析大屏、自动化报表生成等),无需重新安装整个软件,只需更新许可证文件即可。

- 试用与推广:可以给潜在客户提供一个临时许可证,临时开启所有功能供其试用,到期后自动降级为基础版或禁用。

3. 具体实现(结合你的项目):

在证书中定义:在服务端生成证书时,除了

notBefore(生效时间)、notAfter(过期时间)、consumerAmount(用户数)等标准字段外,我们自定义了一个扩展字段,例如叫做features。数据格式:这个

features字段可以是一个用特定分隔符(如逗号)连接的字符串,或者一个JSON数组。 字符串示例:"DATA_VISUALIZATION,AUTO_REPORT,ADVANCED_AI"JSON示例:["DATA_VISUALIZATION", "AUTO_REPORT", "ADVANCED_AI"]客户端校验:

- 客户端程序在启动验证许可证时,除了校验有效期和硬件信息,还会解析出这个

features列表,并将其保存在内存或应用上下文中。 - 在软件代码中,在所有高级功能的入口处(如Controller层的方法),添加校验逻辑。

1

2

3

4

5

6

7

8

9

10// 示例代码:在某个高级功能的Controller方法中

@GetMapping("/generateAdvancedReport")

public ResponseEntity generateReport() {

// 校验当前许可证是否包含此功能权限

if (!licenseService.hasFeature("AUTO_REPORT")) {

// 返回统一的错误响应,提示“您的许可证未包含高级报表功能,请联系销售”

throw new LicenseFeatureNotFoundException("AUTO_REPORT");

}

// ... 正常执行功能逻辑

}- 客户端程序在启动验证许可证时,除了校验有效期和硬件信息,还会解析出这个

管理端操作:市场/销售人员在给客户生成许可证时,可以在管理后台界面上通过勾选复选框的方式来轻松配置该客户有权使用的功能模块。

面试时可以这样总结:“我们通过许可证中的自定义字段实现了功能模块的精细化控制,这让我们的产品从单一版本变成了可配置的、多版本的商业化产品,直接支持了公司的差异化定价和销售策略。”

二、 联调时的具体沟通痛点

联调(前后端联合调试)的痛点通常源于“契约不清晰”和“反馈不明确”,导致大量的沟通成本和重复劳动。

痛点详细说明:

“猜谜游戏”之参数问题:

- 痛点:前端需要调用一个

GET /api/users接口来获取用户列表。 - 场景:后端开发A认为分页参数是

pageNum和pageSize,而前端开发B根据习惯传了page和limit。双方都按自己的理解开发,一到联调就报错,然后开始互相询问:“你到底要传什么参数?” - 你的解决方案:通过强制使用

@ApiParam(required = true)并在Swagger文档中明确写出参数名和是否必填,形成前后端共同遵守的契约。后端看到注解就知道要校验,前端看到文档就知道要传什么。

- 痛点:前端需要调用一个

“黑盒异常”之错误处理问题:

痛点:前端提交表单,后端校验失败,直接抛出一串

NullPointerException或者Spring默认的400 Bad Request,响应体里是一大堆Java异常栈信息。场景:前端拿着这个错误不知所措,只能把截图丢到群里问后端:“这啥意思?是哪个字段错了?” 后端再去翻日志,定位问题,然后回复:“哦,是email字段没传。”

你的解决方案:通过全局异常处理(@ControllerAdvice) 和标准化API响应体,将所有异常转换为前端能直接理解和展示的格式。

1

2

3

4

5

6

7

8

9

10

11

12

13// 改造前(混乱且无法解析):

"timestamp": "2023-...",

"status": 400,

"error": "Bad Request",

"trace": "java.lang.NullPointerException: null at com.example.Controller..."

// 改造后(清晰且可编程):

{

"success": false,

"code": "USER_EMAIL_REQUIRED", // 唯一的错误码,前端可以用它做多语言映射

"message": "邮箱地址为必填项", // 直接可展示给用户的友好信息

"data": null

}这样,前端可以轻松地:

if (response.code === 'USER_EMAIL_REQUIRED') { alert('请填写邮箱'); }

“类型黑洞”之数据格式问题:

- 痛点:后端某个字段设计为

Integer类型,前端传了个字符串"123",Spring可能自动转换了,但有时又会转换失败报错。或者日期格式不统一(yyyy-MM-ddvsyyyy/MM/dd)。 - 你的解决方案:通过强大的后端校验注解(如

@NotNull,@Email,@Pattern) 和统一的异常处理,在接口入口就明确拒绝格式错误的请求,并返回非常具体的错误信息(如“生日日期格式应为YYYY-MM-DD”),而不是一个笼统的“参数错误”。

- 痛点:后端某个字段设计为

“沟通孤岛”之文档滞后问题:

- 痛点:后端接口改了(如字段名变了、接口地址变了),只是口头跟前端说了一声,或者改了忘了说。前端在不知情的情况下继续开发,等到联调时才发现接口对不上,双方都很恼火。

- 你的解决方案:通过Swagger/OpenAPI等工具,让API文档随着代码自动生成。代码即文档,后端一旦修改代码并更新了注解,文档就会自动更新,前端可以随时查看最新的接口约定,从根本上减少此类问题。

面试时可以这样总结:“联调的主要痛点本质是契约混乱和反馈无效。我们通过 ‘标准化响应体 + 全局异常处理’ 解决了反馈问题,让错误信息可读可处理;通过 ‘强制注解 + Swagger自动化文档’ 解决了契约问题,让接口约定清晰且实时同步。这直接将我们团队的联调周期从3天缩短到了1.5天。”

山西中维

2025 年 9 月 14 日

当然,这是一个非常详细的、基于你第二段项目经验的“参考答案库”。请结合你自己的实际理解进行微调,使其成为你自己的答案。

一、 关于“性能优化”的回答思路

1. 深度追问

Q: 你是怎么发现这个接口需要优化的?

A: 主要通过两种方式:

- 监控告警:我们项目接入了基础的监控,当接口响应时间超过1秒时会有日志告警。这个接口频繁触发告警。

- 前端反馈:前端同事和测试同事在联调/测试时,直接反馈这个页面加载非常慢,体验很差。我们随后在后端日志中确认了该接口的响应时间确实在1.2秒左右。

Q: 详细讲一下你使用Explain分析SQL的过程?你看到了什么?

A: 我拿到这个慢接口对应的SQL语句后,在MySQL客户端前加上了 EXPLAIN 关键字执行。

1 | |

我重点关注了几个字段:

- type: ALL: 这最致命,表示进行了全表扫描(Full Table Scan),说明MySQL正在逐行检查整个表来找到匹配的行。

- rows: 一个大数值: 比如几万甚至更多,这表示MySQL认为必须检查的行数非常多。

- possible_keys: NULL & key: NULL: 表示没有合适的索引可用,MySQL也无法使用任何索引来执行这个查询。

- Extra: Using where: 表示在存储引擎检索行后进行过滤。

看到这些结果,结论就很明确了:因为没有索引,MySQL不得不进行全表扫描来执行模糊查询,导致性能急剧下降。

Q: 你具体是加了什么索引?为什么选择这些字段?

A: 我针对 dept_name 字段创建了一个普通的二级索引(Secondary Index)。

1 | |

- 为什么选这个字段:因为

WHERE子句的查询条件就是基于dept_name的模糊匹配。这是查询的驱动字段。 - 为什么不是复合索引:因为这个查询的过滤条件只有这一个字段,没有其他联合查询条件,所以单列索引就足够了。

- 注意点:我也知道对于

LIKE '%关键词%'这种前导通配符的查询,即使加了索引也可能失效。但在我们的业务场景和MySQL版本中,添加索引后通过EXPLAIN再次查看,type变成了range(范围扫描),key显示使用了idx_dept_name,证明索引是生效的,效果立竿见影。

Q: 除了加索引,还做了其他优化吗?

A: 这是一个非常好的问题。加索引是主菜,但我还做了一些“配菜”:

- **避免 SELECT :我修改了SQL语句,将

SELECT *替换为SELECT id, name, phone...,只查询业务需要的具体字段*。这减少了网络传输的数据量,特别是在表字段很多的情况下,对性能也有提升。 - 考虑缓存:这个接口的数据变更频率不高(部门名称不会老是变)。如果后续性能要求更高,可以考虑引入Redis,将查询结果缓存起来,下次同样请求直接返回缓存数据。

2. 原理延伸

Q: 在什么情况下,即使加了索引也不会生效?(索引失效场景)

A: 常见的索引失效场景有:

- 对索引列进行运算或函数操作:例如

WHERE YEAR(create_time) = 2023,即使create_time有索引也会失效。应改为范围查询WHERE create_time BETWEEN '2023-01-01' AND '2023-12-31'。 - 使用左模糊或全模糊查询:

LIKE '%abc'或LIKE '%abc%'会导致索引失效。右模糊LIKE 'abc%'仍然可以走索引。 - 数据类型隐式转换:例如索引字段是字符串类型

varchar,查询时用了WHERE code = 123(数字),MySQL会做类型转换,导致索引失效。 - 不符合最左前缀原则:对于复合索引

(a, b, c),查询条件没有包含最左边的列a,索引可能失效。 - 使用 OR 连接:如果

WHERE a = 1 OR b = 2,如果a和b是单独索引,可能不会使用索引。优化方法是改用UNION。 - 评估使用索引比全表扫描还慢:当表中数据量很少时,MySQL优化器可能认为直接全表扫描比走索引再回表更快。

二、 关于“技术实现”的回答思路

Q: 为什么选择EasyExcel而不是Apache POI?

A: 这是基于内存占用和使用便捷性的综合考量。

- Apache POI: 功能强大,但它在处理大数据量(比如上万行)的Excel时,采用的是将整个文件加载到内存的模型(DOM解析),非常容易导致JVM内存溢出(OOM),性能也较差。

- EasyExcel: 它的核心优势是逐行解析的监听器模式(SAX解析)。它不会一次性把整个文件读入内存,而是逐行读取解析,处理一行,释放一行的内存。内存占用极低,非常适合处理大数据量的导入导出,这也是我们选择它的最主要原因。此外,它的API设计也更友好,简化了开发。

Q: 说一下监听器机制是怎么工作的?

A: 以数据导入为例:

- 我定义了一个自定义的

AnalysisEventListener,例如EmployeeExcelListener。 - 在

invoke()方法中,EasyExcel每解析一行数据,就会将这一行数据作为一个对象(如EmployeeDTO)传入这个方法。我在这里进行数据校验和业务处理(比如存入一个临时List)。 - 在

doAfterAllAnalysed()方法中,当所有行都解析完毕后,会触发这个方法。我在这里进行批量入库操作(例如MybatisPlus的saveBatch),而不是解析一行插入一行,这极大地提高了效率。 - 整个过程内存中只会保持一批数据(比如1000条),而不是全部数据,完美避免了OOM。

Q: MyBatis-Plus相比原生MyBatis有哪些优点?

A: MP是一个强大的增强工具,而不是替代品。它的核心优点就四个字:简化开发。

- 强大的CRUD封装:内置了通用Mapper(

BaseMapper)和通用Service(IService),单表查询无需编写任何XML文件。例如userMapper.selectById(1),userService.list(new QueryWrapper().lambda().eq(User::getName, "张三")),开发效率极高。 - 强大的条件构造器:

QueryWrapper和UpdateWrapper可以通过链式调用轻松构建复杂且安全的查询条件,有效避免了SQL拼接的麻烦和SQL注入的风险。 - 丰富的插件:如分页插件(无需手动

count和limit)、性能分析插件(输出SQL执行时间)等,开箱即用。 - 代码生成器:这正是我项目中用到的,可以根据数据库表自动生成Entity、Mapper、XML、Service、Controller等全套代码,极大减少了初始搭建项目的重复劳动。

三、 关于“业务与项目”的回答思路

Q: “智能名片生成”是怎么实现的?

A: 我们的实现方案是动态生成H5页面。

- 后端设计一个名片数据的API接口,返回用户的所有信息(姓名、职位、公司、头像、电话等)。

- 前端(Vue.js)拿到这些数据后,填充到一个预先设计好的名片模板中。

- 用户分享出去的是一个带有用户ID参数的H5链接(如

https://.../card.html?userId=123)。 - 任何人点击这个链接,都会访问前端页面,前端再根据URL中的

userId去调用后端接口获取数据并渲染展示。

- 优点:灵活,易于更新(用户信息改了,名片内容自动变),且易于追踪访问数据。

Q: “人脉圈留言功能”的数据库表是怎么设计的?

A: 核心表是一张 comment 表,主要字段包括:

id: (BIGINT) 主键business_card_id: (BIGINT) 被留言的名片ID,外键关联到名片表user_id: (BIGINT) 留言者的用户IDcontent: (TEXT) 留言内容parent_id: (BIGINT) 自关联外键,用于实现回复功能。如果为0,则是顶级留言;如果有值,则是回复某条留言的回复。create_time: (DATETIME) 创建时间- 索引:会在

business_card_id和create_time上建立索引,方便根据名片ID查询并按时间排序。

Q: 你一般在禅道上提交Bug会包含哪些信息?

A: 我会尽量提供一次完整的信息,减少来回沟通的成本。一个规范的Bug提交通常包括:

- 标题:简短清晰地描述问题(如:【名片详情页】点击分享按钮无响应)。

- 环境:测试环境/生产环境,浏览器型号版本。

- 复现步骤: step1, step2, step3… 清晰描述如何操作会必然导致这个问题。

- 预期结果:期望的正常表现是什么。

- 实际结果:目前发生的异常表现是什么(最好附上截图或录屏)。

- 错误日志:如果是后端Bug,我会附上从服务器日志中查到的相关错误栈信息(StackTrace),这是最关键的解码信息。

- 关联:会关联到对应的需求或任务。

希望这些详细的回答能帮助你更好地准备面试。请务必结合你自己的实际经验来理解和调整这些答案,做到心中有数,对答如流。祝你成功!

基本导入,模型映射导入,导入类型转换器,导入监听器,导入异常处理,文件导入。

基本导出,模型映射导出,导出格式转换,排除指定列,导出行高行宽,合并单元格导出,

核心问题

2025 年 9 月 15 日

非常好!这是一个绝佳的机会来展示技术的深度和广度。我将以一名资深工程师和技术面试官的身份,为你逐一解答这些问题。这些答案不仅提供了事实,还包含了背后的原理、实践中的权衡以及更深入的思考,你可以借此来提升自己的理解。

一、Java 基础与规范

1. HashMap 原理

- 底层结构:JDK 1.8 后是“数组 + 链表 + 红黑树”。数组是主干,每个数组元素是一个

Node(链表)或TreeNode(树)。 - 哈希冲突:通过

hash(key)计算数组下标,不同 key 可能算出相同下标,这就是冲突。解决方法是“链地址法”,即在该下标处形成链表。当链表长度超过 8 且数组总长度超过 64 时,链表转为红黑树,以提升查询效率(从 O(n) 提升到 O(log n))。 - ConcurrentHashMap vs Hashtable:

Hashtable用synchronized锁住整个对象,并发度低。ConcurrentHashMap在 JDK 1.7 使用“分段锁”,1.8 改为更高效的CAS+synchronized(只锁住数组的某一个桶/链表头节点),并发度大大提升。

2. ArrayList vs LinkedList

- 区别:

ArrayList基于动态数组,随机访问快(get(i)O(1)),但中间插入删除慢(需要移动元素,O(n))。LinkedList基于双向链表,插入删除快(只需修改指针,O(1)),但随机访问慢(需遍历,O(n))。 - 扩容:

ArrayList初始容量 10,扩容时newCapacity = oldCapacity + (oldCapacity >> 1)(即 1.5 倍),然后将旧数组数据拷贝到新数组。

3. 自定义注解

- 定义:

@Target(ElementType.METHOD)表示该注解用于方法;@Retention(RetentionPolicy.RUNTIME)表示注解在运行时可用,这样我们才能通过反射解析它。 - 解析:通常结合 AOP 或 反射。例如,定义一个

@Permission(role="admin")注解。在 AOP 的切面中,通过JoinPoint.getSignature().getMethod().getAnnotation(Permission.class)获取注解,然后判断当前用户角色是否匹配。

4. Lambda & Stream

- map vs flatMap:

map是一对一映射,将元素转换成另一个元素。flatMap是一对多映射,将每个元素转换成一个Stream,然后把所有Stream扁平化连接成一个Stream。例如,将List<List<String>>扁平化为List<String>。 - 并行流注意:并行流使用

ForkJoinPool,任务拆分和合并有开销,数据量小可能更慢。要确保操作是无状态、无干扰、可 associative 的,否则易出错。

二、SpringBoot & 整合

1. 自动配置原理

核心是 @SpringBootApplication -> @EnableAutoConfiguration -> Import(AutoConfigurationImportSelector.class)。

AutoConfigurationImportSelector 会读取 META-INF/spring.factories 文件中的大量自动配置类(如 DataSourceAutoConfiguration)。这些配置类使用 @ConditionalOnClass/MissingBean 等条件注解,按需加载配置。例如,@ConditionalOnClass(DataSource.class) 表示类路径下存在 DataSource 类时,该自动配置才生效。

2. Hutool 价值

它提供了通用工具方法,避免了“造轮子”,提升了开发效率和代码可读性。例如:DateUtil.format、HttpUtil.get、StrUtil.isBlank、BeanUtil.copyProperties 等,封装了常用操作,减少了冗余代码。

三、MySQL & 性能优化

1. Explain 解读

- type:

ALL(全表扫描,最差)->index(全索引扫描)->range(索引范围查询)->ref/eq_ref(唯一索引查询)->const(最佳)。 - key:实际使用的索引。

- rows:预估需要读取的行数,越小越好。

- Extra:

Using filesort(需额外排序)、Using temporary(需用临时表)都是需要优化的信号。

2. 最左前缀原则

对于复合索引 (a, b, c),它可以有效用于查询 (a), (a, b), (a, b, c)。但如果查询条件是 (b) 或 (b, c),该索引无效。

3. 索引失效场景

- 对索引列进行计算或函数操作:

WHERE YEAR(create_time) = ... - 类型隐式转换:

varchar列传入int值。 - 左模糊查询:

LIKE '%abc'。 - 不符合最左前缀原则。

四、Redis & 缓存

1. BitMap 签到

- Key:

user:sign:{userId}:{yyyyMM} - 签到:

SETBIT key offset 1(offset 为当月第几天) - 检查某天:

GETBIT key offset - 统计连续签到:使用

BITFIELD命令获取一段位域,然后在客户端代码中计算连续为 1 的位数。

2. Lua 脚本 & 原子性

Redis 执行 Lua 脚本时是原子性的,期间不会执行其他命令。这对于需要 “判断+执行” 的复合操作至关重要。例如,秒杀扣库存:

1 | |

3. 缓存一致性

常用策略是:更新数据库,然后删除缓存。

- 为什么不是更新缓存? 因为可能有多个并发写操作,更新顺序无法保证,且计算缓存值可能很耗时。

- 为什么先删缓存再更新数据库不行? 这会导致读请求在缓存删除后、数据库更新前瞬间把旧数据又回写到缓存。

- 更复杂的方案:可以通过 Canal 监听数据库 binlog 来异步删除缓存,保证最终一致性。

五、ElasticStack

1. 高亮 & 建议

- 高亮:在 DSL 查询中添加

"highlight": { "fields": { "content": {} } }。 - 搜索建议:使用

completion suggester。需要在映射中定义类型为completion的字段。查询时在suggest体中指定该字段。

2. 数据同步

- 双写:代码中同时写 DB 和 ES。简单,但难保证一致性。

- Canal/Maxwell:推荐。通过监听 MySQL binlog,实时将数据变更同步到 MQ,再由消费者写入 ES。解耦,对业务无侵入,保证最终一致性。

六、JVM & 底层

1. 内存区域

- 线程共享:堆(Heap)、方法区(Metaspace)

- 线程私有:程序计数器、虚拟机栈(存栈帧、局部变量表等)、本地方法栈。

2. 垃圾收集器

- CMS:老年代收集器,标记-清除算法,追求低停顿,但会产生碎片。

- G1:面向全堆,将堆划分为 Region,采用标记-整理算法,可预测停顿时间,是当前主流。

- ZGC:新一代低延迟收集器,通过染色指针等技术实现停顿时间控制在 10ms 以下。

3. 双亲委派模型

一个类加载器收到加载请求时,先不自己加载,而是委派给父加载器尝试加载。只有当父加载器无法完成时,子加载器才自己加载。

- 好处:保证核心类(如

java.lang.Object)的唯一性和安全,不会被用户自定义的类替代。 - 打破场景: JDBC:

DriverManager需要加载由各类数据库厂商实现的Driver接口,这些接口类位于 classpath 下,但需要由启动类加载器加载,这需要通过Thread.currentThread().getContextClassLoader()(线程上下文类加载器)来打破。 Tomcat:每个 Web 应用需要隔离自己的类库,所以每个 WebApp 都有自己的类加载器。

七、性能/安全优化

1. 批处理

Mybatis Plus 的 saveBatch 底层并非真正的 JDBC 批处理,而是分组后一条条 INSERT。真正的高效批处理需要开启 JDBC 的 rewriteBatchedStatements=true 参数,并手动编写 addBatch() 和 executeBatch() 代码。

2. 多级缓存

本地缓存(Caffeine)-> 分布式缓存(Redis)-> 数据库。

- 策略:先读本地,未命中读 Redis,再未命中读 DB 并回填缓存。

- 挑战:如何保证本地缓存的一致性?可通过发布订阅(如 Redis Pub/Sub)来通知所有节点失效本地缓存。

3. 同端互斥登录

用户登录时,将 userId 和本次登录的 token 作为键值对存入 Redis。下次登录时,生成新 token,删除旧 token(强制旧客户端token失效),并存入新 pair。

八、Nginx

拦截IP:在

location块或http块中使用deny 192.168.1.1;或allow/deny组合。解决跨域:在

location块中配置:1

2

3

4add_header Access-Control-Allow-Origin *;

add_header Access-Control-Allow-Methods 'GET, POST, OPTIONS';

add_header Access-Control-Allow-Headers 'DNT,User-Agent,X-Requested-With,If-Modified-Since,Cache-Control,Content-Type,Range,Authorization';

if ($request_method = 'OPTIONS') { return 204; } # 处理预检请求负载均衡:

upstream块中定义服务器组,在location中proxy_pass到该组。策略有轮询、weight(权重)、ip_hash(同一IP固定到一台服务器)。

九、SpringCloud & 微服务

1. Nacos vs Eureka

- Eureka:AP 架构,保证高可用,但可能读到旧数据。

- Nacos:同时支持 CP 和 AP 模式。还提供强大的配置中心功能,这是 Eureka 没有的。Nacos 集群基于 Raft 协议,性能更高。

2. OpenFeign 原理

它基于动态代理。你定义接口后,Feign 会在运行时为你创建一个实现类。发起的请求会被拦截器处理,然后由 Ribbon(负载均衡器)从服务注册中心(如 Nacos)获取服务实例列表,并选择一个实例,最后通过 HTTP 客户端(默认是 JDK 的 HttpURLConnection,可替换为 OKHttp)发送请求。

3. 微服务改造挑战

- 拆分粒度:如何划分微服务?(按业务域划分,如用户服务、订单服务)

- 分布式事务:如何保证跨服务的数据一致性?(引入 Seata 或采用最终一致性方案,如可靠事件模式)

- 联调测试:环境更复杂,需要更好的 API 管理和文档工具(如 Swagger + OpenAPI)。

十、RBAC & SpringSecurity

1. RBAC 表结构

5张核心表:用户表 -> 用户-角色中间表 -> 角色表 -> 角色-权限中间表 -> 权限表。

权限表通常存储权限字符串,如 user:delete。

2. SpringSecurity 流程

请求经过一系列 过滤器链。JWT 校验通常在自定义的 JwtAuthenticationFilter 中完成,该过滤器应放在链的前部。它解析 token,成功后会将认证信息存入 SecurityContextHolder。后续的授权过滤器(如 FilterSecurityInterceptor)会从中获取信息进行鉴权。

springboot3整合SpringSecurity实现登录校验与权限认证(万字超详细讲解)_springboot security-CSDN博客

3. 方法级注解

需要在配置类上添加 @EnableGlobalMethodSecurity(prePostEnabled = true) 来启用 @PreAuthorize。其原理是基于 AOP,在方法调用前进行权限切面检查。

十一、Docker

高效 Dockerfile:

1 | |

使用 .dockerignore 忽略 .git, *.md, target/ 等文件,加速构建和减小镜像上下文。

十二、Spring AI & AI 应用 (核心亮点)

1. RAG (Retrieval-Augmented Generation)

- 工作流: 知识库处理:将文档(PDF、Word等)进行分块。 向量化:使用 Embedding 模型(如 OpenAI text-embedding-ada-002)将文本块转换为向量。 存储:将这些向量存入向量数据库(如 ChromaDB, Pinecone)。 检索:用户提问时,先将问题向量化,然后在向量库中检索最相似的 Top-K 个文本块。 增强生成:将检索到的文本块作为上下文,与用户问题一起组合成 Prompt,发送给 LLM(如 GPT-4)。LLM 基于这些知识生成回答,避免幻觉。

2. 工具调用 (Function Calling)

LLM 本身无法执行代码、查询数据库。工具调用允许 LLM 理解用户请求后,决定需要调用哪个工具(函数),并生成符合函数参数的 JSON 数据。应用程序执行该函数,将结果返回给 LLM,LLM 再组织成最终回答。

- 例子:用户问“北京天气怎么样?”。LLM 识别出需要调用

get_weather(location: string)函数,并生成{"location": "北京"}。程序执行天气查询 API,将结果返回,LLM 总结:“北京今天晴,25摄氏度。”

3. MCP (Model Context Protocol)

由 OpenAI 提出,是一种标准化协议,用于让 LLM 与外部工具、数据源和服务进行更安全、高效的交互。它解决了不同工具集成方式不一、难以管理的问题。MCP 服务器提供工具,MCP 客户端(如 AI 应用)通过标准协议与服务器通信,使 LLM 能无缝使用这些工具。

4. 会话记忆 (Session Memory)

通常将完整的对话历史(或摘要)存储在外部(如 Redis),并以 session_id 为键。每次请求时,将历史记录作为上下文再次发送给 LLM,从而实现连续对话的能力。

十三、开发工具 & 效率

1. Git 工作流

常用 Feature Branch Workflow:

- 从

develop分支切出feature/user-auth。 - 在特性分支上开发、提交。

- 完成後,向

develop发起 Pull Request(合并请求)。 - 代码评审(Code Review)通过后,合并到

develop。 - 这是一种非常清晰和协作友好的流程。

2. AI 助手提效

- 代码生成:快速生成样板代码、单元测试、SQL查询。

- BUG 排查:将错误日志贴给它,让它帮助分析可能的原因。

- 学习新技术:让它解释概念、提供入门示例代码。

- 代码重构:建议更好的写法、识别代码坏味道。

希望这些深入的回答不仅能帮助你应对面试,更能加深你对这些技术的理解。祝你马到成功!

重点知识总结

操作系统

进程调度:

先来先服务:先来后到

最短作业优先:长作业可能没有执行机会

高响应比优先:等待时间 + 执行时间 / 执行时间,等待时间越长,长作业就越有机会被执行

时间片轮转:为每个进程分配时间片,用完或者提前结束,其他进程就可以抢占 CPU,不好把控时间片大小

最高优先级:为进程设置优先级,静态优先级、动态优先级,优先级低的可能没有执行机会

多级反馈队列调度:多个阻塞队列,按照不同的优先级排列,优先级越低的队列,可执行时间越长。

Java 中的锁机制

Java 中的锁机制是用于处理多线程并发情况下数据一致性的重要工具。在 Java 中,有多个层面的锁机制,包括 synchronized 关键字和 Lock 接口等。

- synchronized 关键字

- 这是 Java 语言内置的一种锁机制。

- 它可以用来实现对代码块或方法的同步控制,确保同一时刻只有一个线程可以执行被锁定的代码块或方法。

- 当一个线程获取锁时,它会将对象头中的标志位设置为锁定状态,其他线程在尝试获取锁时,如果发现标志位已被设置为锁定状态,就会进入等待状态,直到锁被释放。

- Lock 接口

- 提供了比 synchronized 更灵活的锁机制。

- 它提供了显式的锁获取和释放操作,允许更细粒度的控制。

- Lock 接口有多种实现,包括 ReentrantLock 等。

在 Java 的锁机制中,还可以根据锁的特性进行进一步分类:

- 公平锁与非公平锁

- 公平锁:按照线程申请锁的顺序来获取锁,类似于日常排队。

- 非公平锁:线程获取锁的顺序并不是按照申请锁的顺序,可能存在插队现象。

- 可重入锁(递归锁)

- 允许同一线程在外层方法获取锁后,进入内层方法时仍能持有该锁并继续运行。

- 自旋锁

- 当线程尝试获取锁失败时,不是立即阻塞等待,而是采用循环的方式尝试获取锁。

- 这可以减少线程上下文切换的消耗,但当循环次数过多时,会消耗 CPU 资源。

- 读写锁

- 分为写锁和读锁。写锁是独占锁,一次只能被一个线程持有;读锁是共享锁,可被多个线程持有。

- 读写锁适用于读操作远多于写操作的场景,可以大大提高读操作的性能。

Java 的锁机制为多线程编程提供了丰富的工具,开发者可以根据具体的业务需求选择适合的锁类型,以确保数据的一致性和线程的安全性。

推荐阅读:[19 你知道哪几种锁?分别有什么特点? (lianglianglee.com)](https://learn.lianglianglee.com/专栏/Java 并发编程 78 讲-完/19 你知道哪几种锁?分别有什么特点?.md)

Synchronized 实现原理

JVM 基于进入和退出 Monitor 对象来实现方法同步和代码块同步,但两者的实现细节不一样。

代码块同步是使用 monitorenter 和 monitorexit 指令实现的,而方法同步是使用另外一种方式实现的。

monitorenter 指令是在编译后插入到同步代码块的开始位置,而 monitorexit 是插入到方法结束处和异常处,

JVM 要保证每个 monitorenter 必须有对应的 monitorexit 与之配对。

任何对象都有 一个 monitor 与之关联,当且一个 monitor 被持有后,它将处于锁定状态。线程执行到

monitorenter 指令时,将会尝试获取对象所对应的 monitor 的所有权,即尝试获得对象的锁。

Java 并发容器

HashMap

HashMap 的put流程和扩容原理是 Java 集合框架中非常重要的部分,下面我将详细地描述这两个过程。

HashMap 的 put 流程

- 计算 key 的哈希值:首先,HashMap 会根据 key 的 hashCode()方法计算出一个哈希值,这个哈希值会用来确定 key 在 HashMap 中的存储位置。

- 计算数组索引:HashMap 内部有一个 Entry 数组,用来存储键值对。计算出的哈希值会进一步通过一个算法(通常是哈希值与数组长度取模)转换成一个数组索引。

- 检查是否存在键值对:在对应的数组索引位置,HashMap 会检查是否已经存在一个键值对。如果存在,并且 key 相同,那么就用新的 value 替换旧的 value。

- 处理哈希冲突:如果计算出的数组索引位置已经有键值对,并且 key 不同,那么就发生了哈希冲突。HashMap 通过链表或红黑树(在 JDK 1.8 及以后版本中,当链表长度超过一定阈值时,会转换为红黑树)来解决哈希冲突。

- 插入新的键值对:如果数组索引位置是空的,或者 key 相同但 value 需要更新,那么就在该位置插入新的键值对。

HashMap 的扩容原理

当 HashMap 中的元素数量超过数组容量的一定比例(负载因子,默认是 0.75)时,就会触发扩容操作。

- 创建新的数组:HashMap 会创建一个新的数组,其容量通常是原数组容量的两倍。

- 重新计算索引:扩容后,原来的键值对需要根据新的数组长度重新计算索引。由于新的数组长度是原来的两倍,所以原来的哈希值取模的结果要么不变,要么变为原来的索引加上原数组长度。这个特性被称为“幂等扩容”,它保证了在扩容过程中,只需要对原数组中的元素进行一次重新索引操作,而不需要遍历整个数组。

- 移动键值对:HashMap 会遍历原数组中的每个位置,对于每个非空的键值对,重新计算其在新数组中的索引,并将其移动到新的位置。这个过程可能会触发哈希冲突的解决操作(即链表的插入或红黑树的调整)。

需要注意的是,扩容操作是一个相对耗时的过程,因为它涉及到内存的重新分配和键值对的重新索引。因此,在实际使用中,应该尽量避免频繁的扩容操作,可以通过预估合适的初始容量和负载因子来优化 HashMap 的性能。

ArrayList

简单介绍一下 ArrayList:

实现了 RandomAccess 接口,支持随机访问;实现了 Clonable 接口,支持复制;实现了 Serializable,支持序列化传输。

底层使用数组实现,该数组为可变长数组,也称之为动态数组。默认初始容量为 10,超出容量限制会自动扩容 1.5 倍。

扩容就是新建一个 1.5 倍容量大的数组,把原数组内容拷贝到新数组中,将新数组作为扩容后的数组。数组扩容代价很高,使用时应该尽量避免数组扩容,要预知要保存元素的多少,构建 ArrayList 时就指定其初始容量。

remove() 方法有按照索引删除,也有按照元素值删除。会使从所删除元素的下标开始,到数组末尾的元素全部向前移动一个位置,置空最后一位,方便 GC 回收。删除中间元素,需要挪动大量的数组元素,操作代价很大;如果是末尾元素,代价是最小的。

不是线程安全的,只能用在单线程环境下。在多线程环境中,可以考虑使用 Collections.synchronizedList(List l)函数返回一个线程安全的 ArrayList 类。

采用了 Fail-Fast 机制,面对并发的修改时,迭代器很快就会完全失败,报异常 concurrentModificationException(并发修改一次)

add(E e) 实现原理:

ensureCapacityInternal(size +1),修改 modCount 标识自增一,calculateCapacity() 确保数组已使用长度加一后不会溢出,即足够存放下一个元素,不满足就使用 grow() 扩容为原容量的 1.5 倍。

ElementData[size++] = e,添加新元素到数组中。

返回新元素添加成功的布尔值。

add(int index, E element) 实现原理:大同小异。

首先确保要插入元素的位置小于等于当前数组长度,并且不能小于 0,否则抛出异常。

判断是否需要扩容后,确保了数组有足够的容量。使用 System.arraycopy() 将要插入的位置之后的所有元素向后移动一位,再将新的数组元素放到指定位置 ElementData[index] = e。

扩容原理:ArrayList 的扩容原理主要涉及到底层数组的容量调整。当 ArrayList 中的元素数量达到当前数组的容量时,它会自动进行扩容以容纳更多的元素。

具体来说,ArrayList 的扩容过程如下:

- 计算新容量:默认情况下,新的容量会是当前容量的 1.5 倍。这通常是通过将当前容量右移一位(相当于除以 2)然后加上当前容量来实现的。例如,如果当前容量是 10,那么新的容量会计算为 10 + (10 >> 1) = 15。

- 创建新数组:根据计算出的新容量,ArrayList 会创建一个新的数组。

- 复制元素:将原数组中的元素复制到新数组中。这个过程涉及到遍历原数组,并将每个元素依次放入新数组的对应位置。

- 更新引用:将 ArrayList 的内部引用从原数组更新为新数组。

需要注意的是,ArrayList 在初始化时会有一个默认的容量(通常为 10),当第一个元素被添加时,如果还没有进行初始化,那么就会创建一个默认容量的数组。之后的扩容操作都是基于这个原理进行的。

频繁的扩容操作可能会对性能产生影响,因为每次扩容都需要创建新数组并复制元素。因此,在实际使用中,如果可能的话,最好预先估计所需容量并设置合适的初始容量,以减少扩容的次数。

另外,与 ArrayList 不同,LinkedList 是基于双向链表实现的,因此它不需要扩容机制。在 LinkedList 中,添加或删除元素只需要调整链表的节点连接,而不需要像 ArrayList 那样复制整个数组。这使得 LinkedList 在元素增加和删除操作上的效率通常比 ArrayList 要高。

remove() 的实现过程:从列表中删除指定元素,有多种重载形式。按值删除,遍历整个列表寻找给定元素,找到就删除,同时将后面元素向前移动一个位置。按索引删除,直接定位到给定索引的元素,执行删除操作。

remove() 的实现原理:以按照索引删除为例。ElementData 数组根据索引下标找到元素值;根据 size - index - 1 判断删除元素是否为最后一个元素。如果不是最后一个元素,执行 System.arraycopy() 数组拷贝,所有元素向前移动一个位置。最后,把数组最后一位置空,为 null,为 GC 做准备。

Fail-Fast 机制:这是一个错误检测机制,用于在并发修改列表时抛出 ConcurrentModificationException 异常。

当使用迭代器遍历 ArrayList 时,如果列表在迭代过程中被结构性地修改了(例如,通过 add、remove 或 clear 方法),迭代器就会快速失败并抛出 ConcurrentModificationException。结构性修改是指那些改变列表大小的操作,或者那些可能干扰迭代器行为的操作。

这种机制的实现依赖于 ArrayList 内部的一个 modCount 字段。每当列表被结构性修改时,modCount 就会增加。迭代器在每次迭代时都会检查 modCount 是否与迭代器创建时的 expectedModCount 相等。如果不相等,就抛出 ConcurrentModificationException。

如果你尝试在迭代过程中使用 list.remove(item) 来删除元素,就会触发 Fail-Fast 机制并抛出异常。因此,总是应该使用迭代器的 remove 方法来删除元素,当你需要在迭代过程中修改列表时。

虽然 Fail-Fast 机制可以帮助发现并发问题,但它并不是线程安全的解决方案。在多线程环境中,你仍然需要使用适当的同步机制(如 synchronized 块或 Collections.synchronizedList)来确保线程安全。Fail-Fast 机制主要是为了帮助开发者在开发过程中更早地发现并发问题,而不是作为一个完整的并发控制机制。

循环中删除 ArrayList 的元素:

- 使用

ArrayList的remove方法直接删除元素:普通 for 循环通常是通过索引来遍历数组或容器中的元素的,而在循环中删除元素,列表的大小会改变,后续元素会向前移动,可能会抛出数组越界异常问题。 - 使用迭代器的

remove方法:Fail-Fast 机制 - 使用增强型 for 循环删除元素:增强型 for 循环(也称为”foreach”循环)在内部使用迭代器,因此当在循环体内部使用

ArrayList的remove方法时,会抛出ConcurrentModificationException。 - 从列表末尾向前删除元素:这种从后向前迭代的方法特别适用于需要基于索引删除元素的情况,因为它不会受到删除元素后列表大小变化的影响。

普通 for 循环本身不会抛出ConcurrentModificationException

类加载器

类加载器是一个负责加载类的对象,用于实现类加载过程中的加载这一步。每个 Java 类都有一个引用指向加载它的 ClassLoader。类加载器的主要作用就是加载 Java 类的字节码( .class 文件)到 JVM 中(在内存中生成一个代表该类的 Class 对象)。 字节码可以是 Java 源程序(.java文件)经过 javac 编译得来,也可以是通过工具动态生成或者通过网络下载得来。

类加载机制

首先要明确的一点是,JVM 启动的时候,并不会一次性加载所有的类,而是根据需要去动态加载。也就是说,大部分类在具体用到的时候才会去加载,这样对内存更加友好。

对于已经加载的类会被放在 ClassLoader 中。在类加载的时候,系统会首先判断当前类是否被加载过。已经被加载的类会直接返回,否则才会尝试加载。也就是说,对于一个类加载器来说,相同二进制名称的类只会被加载一次。

类加载器分类

JVM 中内置了三个重要的 ClassLoader:BootstrapClassLoader(启动类加载器):最顶层的加载类,由 C++实现,通常表示为 null,并且没有父级,主要用来加载 JDK 内部的核心类库;ExtensionClassLoader(扩展类加载器);AppClassLoader(应用程序类加载器):面向我们用户的加载器,负责加载当前应用 classpath 下的所有 jar 包和类。除了这三种类加载器之外,用户还可以加入自定义的类加载器来进行拓展,以满足自己的特殊需求。

双亲委派模型

每当一个类加载器接收到加载请求时,它会先将请求转发给父类加载器。在父类加载器没有找到所请求的类的情况下,该类加载器才会尝试去加载。

- 在类加载的时候,系统会首先判断当前类是否被加载过。已经被加载的类会直接返回,否则才会尝试加载(每个父类加载器都会走一遍这个流程)。

- 类加载器在进行类加载的时候,它首先不会自己去尝试加载这个类,而是把这个请求委派给父类加载器去完成(调用父加载器

loadClass()方法来加载类)。这样的话,所有的请求最终都会传送到顶层的启动类加载器BootstrapClassLoader中。 - 只有当父加载器反馈自己无法完成这个加载请求(它的搜索范围中没有找到所需的类)时,子加载器才会尝试自己去加载(调用自己的

findClass()方法来加载类)。 - 如果子类加载器也无法加载这个类,那么它会抛出一个

ClassNotFoundException异常

双亲委派模型保证了 Java 程序的稳定运行,可以避免类的重复加载。原因是这样的:JVM 区分不同类的方式不仅仅根据类名,相同的类文件被不同的类加载器加载产生的是两个不同的类。JVM 不仅要看类的全名是否相同,还要看加载此类的类加载器是否一样。只有两者都相同的情况,才认为两个类是相同的。

打破双亲委派模型

自定义加载器的话,需要继承 ClassLoader 。如果我们不想打破双亲委派模型,就重写 ClassLoader 类中的 findClass() 方法即可,无法被父类加载器加载的类最终会通过这个方法被加载。但是,如果想打破双亲委派模型则需要重写 loadClass() 方法。

我们比较熟悉的 Tomcat 服务器为了能够优先加载 Web 应用目录下的类,然后再加载其他目录下的类,就自定义了类加载器 WebAppClassLoader 来打破双亲委托机制。这也是 Tomcat 下 Web 应用之间的类实现隔离的具体原理。

类加载过程

类的加载过程:首先要了解执行 Java 程序之后,由编译器将 Java 代码编译转换为字节码,再由 JVM 逐条解释执行字节码,类的加载就发生在 JVM 解释执行阶段。

当虚拟机要使用一个类时,它需要读取并解析 Class 文件获取相关信息,再将信息存入到方法区。方法区会存储已被虚拟机加载的 类信息、字段信息、方法信息、常量、静态变量、即时编译器编译后的代码缓存等数据。

在加载阶段,通过类的全限定名获取指定类的字节流,将字节流代表的静态存储结构转换为方法区的动态运行时结构,同时在内存中生成 Class 对象,作为将来在方法区访问数据的入口。这里需要了解下 JVM 内存结构和类加载器、双亲委派模型等。

在连接阶段,首先进行 Class 文件格式检查、字节码语义检查、程序语义检查等工作,确保字节流中的信息符合规范。还要进行符号引用验证,确保该类所使用的其他类、方法、字段是否存在。完成类相关信息验证之后,开始为类变量分配内存并赋初值。最后,针对类、接口、类方法和接口方法,JVM 会将常量池内的符号引用替换为直接引用,也就是得到类或字段在内存中的指针或者偏移量,确保了在程序执行方法时,系统能够明确该方法所在位置。

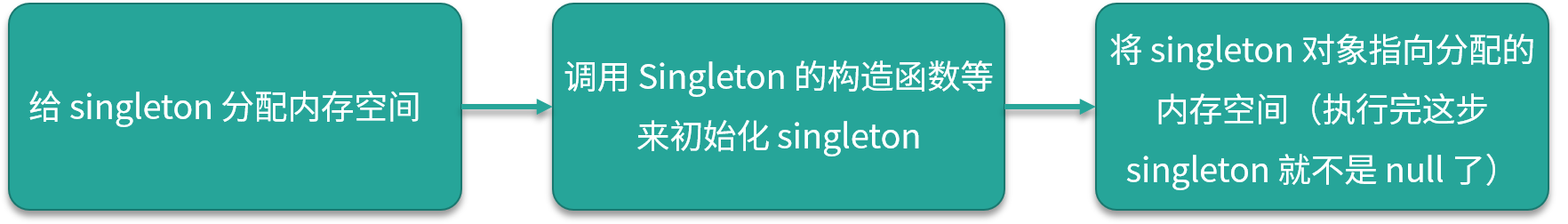

在初始化阶段,作为类加载的最后一个阶段,JVM 开始真正执行指定类的 Java 程序代码,即字节码文件,对类进行初始化,创建类的对象实例。这个阶段我们了解到如果要初始化一个类,首先保证其父类完成初始化。整个初始化过程就是实例化对象并投入使用,过程也简单:在堆中分配内存空间 + 初始化对象 + 将该对象指向堆中分配的内存空间地址。

至此,一个类的加载就已经完成了,并且可以创建实例对象投入使用了。这里需要了解下 Java 对象的创建过程。

使用阶段不必多言,使用完毕之后进入卸载阶段。由于所有的对象实例都存放在堆中,当一个类的所有实例对象都已被 GC,在堆中已经不存在该类的实例对象了、该类没有在任何地方被引用,且该类的类加载器的示例也已被 GC 后,这个类就可以被卸载,即该类的 Class 对象被 GC。这里需要了解一下垃圾回收器、垃圾回收算法等。

JVM 内存模型

运行时数据区域

程序计数器:字节码解释器通过改变程序计数器来依次读取指令,从而实现代码的流程控制,如:顺序执行、选择、循环、异常处理。在多线程的情况下,程序计数器用于记录当前线程执行的位置,从而当线程被切换回来的时候能够知道该线程上次运行到哪儿了。

虚拟机栈:方法调用的数据需要通过栈进行传递,每一次方法调用都会有一个对应的栈帧被压入栈中,每一个方法调用结束后,都会有一个栈帧被弹出。栈由一个个栈帧组成,而每个栈帧中都拥有:局部变量表、操作数栈、动态链接、方法返回地址。和数据结构上的栈类似,两者都是先进后出的数据结构,只支持出栈和入栈两种操作。

- 局部变量表 主要存放了编译期可知的各种数据类型和对象引用。

- 操作数栈 用于存放方法执行过程中产生的中间计算结果和计算过程中产生的临时变量。

- 动态链接 用于管理调用其他方法的符号引用,主要服务一个方法需要调用其他方法的场景。

栈帧随着方法调用而创建,随着方法结束而销毁。无论方法正常完成还是异常完成都算作方法结束。

堆:Java 虚拟机所管理的内存中最大的一块,Java 堆是所有线程共享的一块内存区域,在虚拟机启动时创建。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例以及数组都在这里分配内存。

方法区:当虚拟机要使用一个类时,它需要读取并解析 Class 文件获取相关信息,再将信息存入到方法区。方法区会存储已被虚拟机加载的 类信息、字段信息、方法信息、常量、静态变量、即时编译器编译后的代码缓存等数据。

运行时常量池:Class 文件中除了有类的版本、字段、方法、接口等描述信息外,还有用于存放编译期生成的各种字面量(Literal)和符号引用(Symbolic Reference)的 常量池表(Constant Pool Table) 。

字面量是源代码中的固定值的表示法,即通过字面我们就能知道其值的含义。字面量包括整数、浮点数和字符串字面量。常见的符号引用包括类符号引用、字段符号引用、方法符号引用、接口方法符号。常量池表会在类加载后存放到方法区的运行时常量池中。

以前在永久代即运行时数据区域,现在存放在元空间即本地内存。

字符串常量池:字符串常量池 是 JVM 为了提升性能和减少内存消耗针对字符串(String 类)专门开辟的一块区域,主要目的是为了避免字符串的重复创建。以前在永久代即运行时数据区域,现在存放在堆中。

主要是因为永久代(方法区实现)的 GC 回收效率太低,只有在整堆收集 (Full GC)的时候才会被执行 GC。Java 程序中通常会有大量的被创建的字符串等待回收,将字符串常量池放到堆中,能够更高效及时地回收字符串内存。

直接内存:直接内存的分配不会受到 Java 堆的限制,但是,既然是内存就会受到本机总内存大小以及处理器寻址空间的限制。这些内存直接受操作系统管理(而不是虚拟机),这样做的结果就是能够在一定程度上减少垃圾回收对应用程序造成的影响。

垃圾回收

当前虚拟机的垃圾收集都采用分代收集算法,这种算法没有什么新的思想,只是根据对象存活周期的不同将内存分为几块。一般将 Java 堆分为新生代和老年代,这样我们就可以根据各个年代的特点选择合适的垃圾收集算法。

如果 TLAB 中没有足够的内存空间,就会在共享 Eden 区(shared Eden space)之中分配。如果共享 Eden 区也没有足够的空间,就会触发一次 年轻代 GC 来释放内存空间。如果 GC 之后 Eden 区依然没有足够的空闲内存区域,则对象就会被分配到老年代空间(Old Generation)。

各种垃圾收集器的实现细节虽然并不相同,但总体而言,垃圾收集器都专注于两件事情:

- 查找所有存活对象

- 抛弃其他的部分,即死对象,不再使用的对象。

第一步,记录(census)所有的存活对象,在垃圾收集中有一个叫做 标记(Marking) 的过程专门干这件事。

标记 阶段完成后,GC 进行下一步操作,删除不可达对象。

删除不可达对象(Removing Unused Objects)

各种 GC 算法在删除不可达对象时略有不同,但总体可分为三类:清除(sweeping)、整理(compacting)和复制(copying)。[下一小节] 将详细讲解这些算法。

Java 对象的创建过程

类加载检查:遇到一条 new 指令,指定实例化哪个类,检查该类是否已经加载完成。如果没有,先执行类加载操作。

分配内存:类加载完成,即类加载检查通过后,在堆中为实例对象划分空间,分配内存。根据不同的垃圾回收机制,如果存在内存碎片,即堆内存不规整,虚拟机会维护一个列表分配一块连续的存储空间。如果不存在内存碎片,虚拟机会使用分界指针找到空闲的内存区域来分配内存空间。

初始化零值:虚拟机将所分配的所有内存空间全部初始化零值,实现了对象实例的成员属性有默认值,不赋初始值就能直接使用。

设置对象头:要确保如何根据实例对象找到该对象对应的类,需要设置对象头。对象头中包括了类信息、GC 分代收集年龄、对象哈希码等内容。

执行构造方法:按照程序员意愿初始化对象,至此,Java 对象创建完成。

MySQL

MySQL 默认的 InnoDB 引擎中,索引数据结构是 B+树。索引按数据结构分类可以分为 B 树、B+树、Hash 表等。

索引的运作原理?自平衡的多叉树,按照索引键实现快速检索数据。有主键就用主键作索引键,再者用非空且唯一字段,或者生成一个隐式自增 id 作为索引键。

聚簇索引和非聚簇索引,回表查询,覆盖索引。

MySQL 索引为什么用 B+树?B+树的数据结构特点,都是自平衡树多叉树

- 它只有叶子节点存放数据,非叶子节点只存放索引键(能存放更多的索引键高度更加低,结构更加“矮胖”,磁盘 IO 次数会更少;单点查询,波动更小)

- 叶子节点构成有序链表(范围查询,更快)

- (插入和删除效率更高,有冗余节点,非叶子节点都是冗余节点,不会发生复杂的变化)

如何创建索引?

1 | |

主键索引,唯一索引,普通索引,联合索引什么是最左匹配原则?索引失效的原因有哪些?索引下推是什么?

什么时候需要创建索引?

- 索引的优点:最大的好处就是提高查询速度。

- 缺点:占用的物理空间大;数据量增大、数据的增删改,使得创建索引和维护索引更耗时

所以索引也要在合适的场景下使用。比如字段有唯一性限制的,编码;经常用于作查询条件的,多个字段还可以建立联合索引,提高查询速度;频繁用于排序的字段。表数据量很少、字段频繁更新、区分度不大(男女),就不需要创建索引了。

如何优化索引呢?

当然是使用执行计划分析语句了,explain

- 使用覆盖索引,在指定字段上创建索引,尽量减少回表操作;

- 防止索引失效,模糊匹配、联合索引不遵循最左匹配原则、在查询条件中对索引列做了计算、函数、类型转换等操作,都会发生索引失效,走全表扫描。

执行一条 SQL 语句,期间发生了什么?

一条简单的 select 查询语句,它的执行流程是这样的:

MySQL 架构分为两层:

- Server 层:负责建立连接、分析执行 SQL 语句

- 存储引擎层:负责数据的存储和提取(InnoDB 成为 MySQL 的默认存储引擎,支持并默认使用 B+树索引)

执行过程:

- 连接器:经过 TCP 三次握手,启动 MySQL 服务,验证用户名和密码,获取用户操作权限。默认空闲连接时常为八小时,长短连接。

1 | |

- 查询缓存:键值对保存形式,键为 SQL 查询语句,值为 SQL 语句查询结果。很鸡肋,表频繁更新,查询缓存会被清理,MySQL 8.0 删除了查询缓存。

- 解析 SQL:解析器,词法分析,检查字符串中的字段,找出关键字

select这些;语法分许,更具语法规则,判断是否满足 MySQL 语法,不满足(关键词拼写错误)就出错,满足就构建语法树。 - 执行 SQL:

- 预处理:表不存在、字段不存在

- 优化器:制定执行计划,将 SQL 语句的执行方案确定下来,比如作索引优化,使用覆盖索引避免回表查询等

- 执行器:真正开始执行 SQL 语句,与存储引擎交互。使用聚簇索引也好,使用全表扫描也罢,整体思路就是:执行器的查询过程就是一个 while 循环,会调用一个函数指针,可以理解为调用存储引擎去查询记录。根据制定的 SQL 语句执行计划,存储引擎通过 B+树结构或者全表扫描定位数据记录,将结果返回给执行器,并报告查询完毕。执行器收到存储引擎报告的查询完毕的信息,退出循环,停止查询。

这里可以了解到一个索引优化策略:索引下推。

索引下推是怎样的呢?当联合索引遇到范围查询时,会停止匹配。不用索引下推的话,执行过程是这样的:存储引擎根据指定的 SQL 查询计划,根据联合索引的第一条索引,定位到该记录获取主键值,回表查询整行记录值,并将结果返回给 Server 层。Server 层拿到记录,会再次根据第二条索引判断该记录是否满足,满足就返回记录,不满足就跳过该记录。

使用了索引下推之后,存储引擎在根据联合索引第一条索引定位到记录获取主键值之后,不会先回表查询,而是直接根据第二条索引判断记录是否满足,不满足就直接跳过,满足后再回表查询整行记录值,最后返回结果到 Server 层。

索引下推,就是在联合索引索引失效之后,直接在存储引擎层根据所有索引,过滤出满足的条件的记录主键值之后,才进行回表查询,节省了很多回表操作。

事务

事务有哪些特性?经典的转账问题。原子性(undo log)、持久性(redo log)、隔离性(MVCC,锁机制),才能保证事务的一致性

事务一定要保证隔离性,并发事务可能会带来的问题:脏读(一个事务读到了另一个事务未提交的数据)、不可重复读(两次读取到的数据不一样)、幻读(两次读取到的记录数量不一样)。

这就要提到 SQL 标准提出的四种隔离级别:读未提交、读提交、可重复读和串行化。读提交解决了脏读,一个事务提交了之后,它所做的变更才能被其他事务看到;可重复读解决了不可重复读,事务在执行过程中看到的数据,一直跟这个事务启动时看到的是一样的。MySQL 是通过 MVCC 实现这两种隔离级别的。针对幻读,MVCC 也能解决一部分幻读,比如普通的 select 查询语句是快照读,事务在执行过程中看到的数据,一直跟这个事务启动时看到的是一样的,避免了幻读。而针对当前读,事务读取到的数据总是最新的,使用记录锁 + 间隙锁解决了幻读问题。

那么 MVCC 是如何工作的?明确两点:Read View(快照版本)和聚簇索引记录中的两个与事务有关的隐藏列。

每个事务启动之后,会生成一个 Read View,有四个重要的字段:创建该快照的事务 id、当前数据库中活跃的事务 id 列表(已启动还未提交)、i 最小的事务 id(启动最早的)、应该给到的下一个事务 id。

对于使用 InnoDB 存储引擎的数据库表,聚簇索引记录中的两个与事务有关的隐藏列:当某个事务对该记录进行改动之后,记录该事务 id;隐藏的指针,指向旧的版本记录,形成版本链,通过版本链可以找到修改前的记录。

一个事务去访问记录的时候,除了自己的更新记录可见,会这样做:

- 生成一个 Read View,先判断已经提交的事务:

- 查看该记录的 trx_id,即最近一次对该记录修改的事务 id,比较 Read View 中的 min_trx_id,小,那就是比当前最小的活跃事务都小,说明该提交记录在创建该 Read View 之前就提交了,可见的。

- 查看该记录的 trx_id,即最近一次对该记录修改的事务 id,比较 Read View 中的 max_trx_id,大于等于,那就是比应该给到的下一个事务都大,说明该提交记录在创建该 Read View 之后才提交,不可见的。

- 如果 trx_id 在这两者之间,即该事务在创建 Read View 之后启动,需要判断该事务是否提交。根据快照的活跃事务列表,,仍然活跃,说明未提交,不可见;反之可见。

这就是通过版本链来控制并发事务访问同一个记录的行为,这就是 MVCC。可重复读跟读提交隔离级别的区别就是:前者在启动事务时生成一个 Read View,在整个事务期间都在用这个 Read View,而后者是在每次读取数据时,都会重新生成一个新的 Read View。

Undo log 作用:实现事务原子性、实现 MVCC,Redo log 实现 事务的持久化;Bin log 实现数据恢复和主从同步。

网络传输安全

防止窃听,机密性

- 对称加密算法:通信双方使用唯一的密钥来加密通信数据。

问题:通信之前,如何把用来加密数据的密钥安全地传输给对方?无法保证。

- 非对称加密算法:通信双方各持有一个密钥对,公钥是公开的,私钥自己持有。使用对方的公钥加密数据,只有对方才能用私钥解密

问题:非对称算法的运算速度很慢、性能很差,如果传输过程中频繁使用非对称加密算法加密数据,网络的传输效率是很低的

- 混合加密:将对称加密算法和非对称加密算法结合,通信开始前使用双方使用非对称加密方式传输密钥,保证了密钥的安全传输,此后通信双方可以使用该密钥来加密通信数据,保证了通信数据的保密性。

防止篡改,完整性

- 摘要算法:一种特殊的单向加密的压缩算法,它能够把任意长度的数据“压缩”成固定长度、而且独一无二的“摘要”字符串,就好像是给这段数据生成了一个数字“指纹”。摘要和原数据是完全等价的,加密后的数据无法解密,不能从摘要逆推出原文。发送方把加密后的数据,使用摘要算法生成摘要,把加密数据和该摘要一同发往接收方。接收方使用同样的摘要算法对加密数据进行计算,比照生成的摘要和接受的摘要是否一致,保证了通信数据的完整性。

身份认证,真实性

数字签名:发送方要保证通信数据是真实可信的,不是别人伪造的。使用自己的私钥对摘要加密,生成数字签名。数字签名和加密数据被一同发往接收方。接收方使用发送方的公钥解密,验证签名,拿到摘要,再比对原数据验证完整性。这样就可以像签署文件一样,证明消息确实是发送方发的。

数字证书:接收方能够使用公钥验签,但是公钥是公开的。我们还缺少防止黑客伪造公钥的手段,也就是说,怎么来判断这个公钥就是发送方的公钥呢?CA(证书认证机构)具有极高的可信度,由它来为各个公钥签名,这样的公钥就是可信的。CA 对公钥的签名认证也是有格式的,不是简单地把公钥绑定在持有者身份上就完事了,还要包含序列号、用途、颁发者、有效时间等等,把这些打成一个包再签名,完整地证明公钥关联的各种信息,形成数字证书。

通信双方的数据是加密传输的,保证了数据是保密的,没有被窃听;使用摘要保证了数据的完整性,没有被篡改;使用数字签名,保证了发送方的身份是可靠的,没有被伪造;使用数字证书,保证了接收方的身份是可信的。

Redis 基础

熟悉 Redis 基础知识:什么是 Redis,Redis 为什么这么快,Redis 线程模型,Redis 内存管理,Redis 底层数据结构

Redis 缓存

熟悉常见的生产问题:缓存雪崩,缓存击穿,缓存穿透,保证 Redis 缓存和数据库的一致性(即 Redis 读写策略)

Redis 持久化

AOF 日志:

写后日志,先执行命令,后写日志,然后把日志写入内存缓冲区,在合适的时机刷入磁盘(避免写入错误的命令,减小检查开销;不会阻塞当前的写入操作)

写后日志也会带来问题:不阻塞当前写操作,但可能会阻塞后面的写操作;先执行命令后,服务挂了,日志没有及时写入。这就要研究 AOF 写入磁盘的时机了。

同步写回:每条命令执行完毕,立刻写回磁盘;每秒写回:每隔一秒把缓冲区内容写回磁盘;不写回,由操作系统判断合适的时机写回磁盘。这三种策略性能越来越好,对主线程的影响越来越小;但数据完整性越来越差,可能导致更多的数据丢失,无法及时写回磁盘。

随着写命令越来越多,AOF 文件会越来越大:文件过大,无法保存;文件过大,追加命令的效率变低;文件过大,数据恢复效率变低。

Redis AOF 重写日志。AOP 日志记录的内容就是具体的键值和命令,扫描整个日志文件,只保存最新的数据:把旧文件中的多条命令,改写为一条命令,减小日志文件体量。

AOF 重写日志也会阻塞主线程,重写的过程很有趣(一次拷贝,两个日志):

总的来说,AOF 日志文件能很好地保证数据完整性,尽最大限度减少数据丢失,但数据恢复有点慢。

RDB 快照:

直接记录某一时刻的数据,写入内存中,再写回磁盘。

我们要对哪些数据做快照?快照期间,数据还能变化吗?

Redis 提供了两个命令来生成 RDB 文件,分别是 save 和 bgsave。save 会阻塞主线程,bgsave 会创建一个子线程,专门用来执行全量快照。

写时复制机制:现在保证了执行快照期间,可以不阻塞主线程。那么如何保证执行快照的同时,主线程也能正常执行写操作,变化数据呢。

写时复制机制保证快照期间数据可修改,这个过程也很有趣(拟修改,数据副本):

如何控制快照频率?频繁地执行全量快照写入磁盘,会给磁盘带来很大压力。可以执行增量快照,只写入变化的数据。这就需要记住哪些数据被修改(键值对),也会带来空间性能开销。

总的来说,RDB 快照实现了数据的快速恢复,但是不能很好的保证数据的完整性,因为频率不好把控。

混合持久化:设置合适的快照间隔,在两次快照的间隔期间,使用 AOF 日志持久化。AOF 日志能很好地解决两次快照期间的数据丢失问题,当第二次快照执行完毕,前一次 AOF 日志就可以直接清空,使用新的 RDB 快照进行快速回复就行了。这个方法既能享受到 RDB 文件快速恢复的好处,又能享受到 AOF 只记录操作命令、尽可能保证数据不丢失的简单优势。

Redission 分布式锁

解决问题:分布式锁,即分布式系统中的锁,主要用于在分布式系统中控制共享资源的访问。

主要基于 Redis 的 setnx 命令实现,还使用 lua 脚本保证了释放锁的原子性。

实现原理:

多个客户端同时竞争锁。客户端在尝试获取锁时,向 Redis 发送 setnx 命令,设置一个随机的 UUID 作为 value。如果设置成功,则说明该客户端抢到锁了,可以执行临界区的代码。如果设置失败,客户端可以选择等待一段时间再次获取,或者直接立即返回。临界区代码执行完毕,该客户端需要释放锁,使用 lua 脚本实现正确释放锁,保证释放锁的原子性。为了防止执行过程中崩溃导致锁无法及时释放,还实现了锁的自动续期机制。使用定时任务,当客户端持有锁时,延长锁的过期时间。用户释放锁,就取消定时任务,直接释放锁。

使用步骤:根据 key 创建锁对象,并在临界区代码前后分别调用 lock()和 unlock()方法来获取和释放锁。

Reddssion 分布式限流

解决问题:在分布式系统中,对系统的访问进行限流,以避免过多的请求导致系统崩溃。

主要基于 Redis 的 list 数据结构实现,还使用 lua 脚本保证获取和释放令牌的原子性。

实现原理:

当客户端请求到达,会向 Redis 发送一个 lua 脚本尝试获取令牌,即往 list 数据结构中添加一个元素,list 容量反映了令牌发放的数量。客户端成功获取到令牌,就可以进行接下来的操作。如果 list 已满,即达到最大容量,客户端就获取不到令牌。此时客户端可以选择等待、重试。为了防止令牌堆积,实现了令牌的过期机制,当令牌存在的时间超过一定阈值,就会自动移除令牌。

使用步骤:根据 key 创建限流器对象,设置每秒生成多少令牌,刷新间隔为多少,调用 tryAcquire()方法尝试获取令牌。

常见的限流算法:主要包括计数器限流、滑动窗口限流、漏桶限流和令牌桶限流。这些算法都用于控制接口或服务的访问频率,以避免系统过载或崩溃。

- 计数器限流

- 原理:在固定时间段内记录并限制接口调用的次数。例如,设定每分钟只能调用 100 次接口。

- 实现:每次接口被调用时,计数器加 1。如果当前时间与第一次调用时间的间隔不超过设定时间段(如 1 分钟),且计数器超过限定的次数(如 100 次),则拒绝新的调用。

- 缺陷:在时间段临界值附近,如果请求密集,可能导致单位时间内调用次数超过限流次数。

- 滑动窗口限流

- 原理:以时间窗口为滑动单位,记录并限制在窗口时间内的接口调用次数。

- 实现:窗口随时间滑动,每次检查当前时间窗口内的调用次数是否超过限定值。

- 优点:解决了计数器限流在临界值附近的问题。

- 漏桶限流

- 原理:将请求比作水,漏桶比作系统处理能力。无论流入多少水,漏桶流出的水是恒定的。

- 实现:请求按照固定速率流出,当请求流入速率超过漏桶的流出速率时,多余的请求会被拒绝。

- 特点:限制了请求的流出速率,平滑了突发请求。

- 令牌桶限流

- 原理:系统以固定速率往令牌桶中添加令牌,每次请求需要消耗一个令牌。

- 实现:如果请求到来时桶中有令牌,则消耗一个令牌并处理请求;否则,拒绝请求。

- 特点:允许一定程度的突发流量,只要桶中有令牌就可以处理请求。

这些限流算法各有特点,选择哪种算法取决于具体的业务场景和需求。例如,计数器限流实现简单但可能存在临界值问题;滑动窗口限流解决了临界值问题但实现相对复杂;漏桶限流平滑了突发请求但可能限制了系统的处理能力;令牌桶限流则允许突发请求并提供了较好的灵活性。

Redission 分布式 session

当然,基于 Redis 的分布式 Session 是一种解决分布式系统中 Session 共享问题的方案。下面我尽量用简单明了、通俗易懂的方式为您介绍。

首先,我们要明白什么是 Session。Session 简单来说,就是服务器为每一个客户端(如浏览器)创建的会话,用来保存用户的状态信息。在传统的单机系统中,Session 信息通常保存在服务器的内存中。

然而,当我们的系统变成分布式系统,也就是说有多个服务器节点时,问题就出现了。因为每个节点都是独立的,它们之间的 Session 信息并不共享。这就会导致一个用户从一个节点登录后,访问另一个节点时却需要重新登录,因为那个节点没有他的 Session 信息。

为了解决这个问题,我们可以使用 Redis 来实现分布式 Session。Redis 是一个高性能的内存数据库,可以作为共享存储来保存 Session 信息。

基于 Redis 的分布式 Session 的原理是这样的:当用户在一个节点上登录时,服务器会在 Redis 中为这个用户创建一个 Session,并保存用户的状态信息。然后,服务器会把这个 Session 的 ID 返回给客户端(通常是放在 Cookie 里)。接下来,无论用户访问哪个节点,这个节点都会从 Redis 中根据 Session ID 获取用户的 Session 信息,从而知道用户的状态。

这种方式的好处是,所有的 Session 信息都保存在 Redis 这个共享的存储中,所以无论用户访问哪个节点,都能获取到正确的 Session 信息。这就实现了 Session 的共享,解决了分布式系统中的 Session 问题。

总的来说,基于 Redis 的分布式 Session 是一种高效、可靠的解决方案,能够让我们在分布式系统中方便地管理用户的会话状态。

定时任务的原理

简单来说,@Scheduled 注解在 Spring 框架中就像一个定时钟,你可以告诉它每隔多少时间或者按照什么规律来执行某个方法。当 Spring 应用启动时,它会检查哪些方法上使用了这个注解,并按照设定的规则自动去调用这些方法。这样,你就可以很方便地实现定时任务,比如每天定时发送邮件、每小时检查一次数据库等,而不需要手动去编写复杂的线程和调度逻辑。

在 Java 中,@Scheduled 注解通常与 Spring 框架一起使用,用于实现定时任务。这个注解提供了一种简洁的方式,使得开发者可以很容易地配置定时任务,而无需手动创建和管理线程。

以下是 @Scheduled 注解的一些关键点及其工作原理:

- 注解定义:

@Scheduled是 Spring 框架中的一个注解,它用于标记一个方法作为定时任务。这个注解可以定义任务的执行频率、开始延迟等。 - 配置:

为了使用@Scheduled注解,你需要在 Spring 配置中启用任务调度功能。这通常通过在配置类上添加@EnableScheduling注解来完成。 - 任务注册:

当 Spring 容器启动时,它会扫描所有带有@Scheduled注解的方法,并将这些方法注册为定时任务。 - 任务调度器:

Spring 内部使用一个任务调度器(例如,基于 Java 的ScheduledThreadPoolExecutor)来管理这些定时任务。调度器会根据@Scheduled注解中定义的规则(如固定速率、固定延迟或 Cron 表达式)来安排任务的执行。 - 线程管理:

调度器使用一个线程池来执行这些任务,这意味着多个定时任务可以并发执行。线程池的大小和配置可以根据需要进行调整。 - 异常处理:

如果定时任务在执行过程中抛出异常,Spring 会捕获这个异常并记录它。你可以配置异常处理器来进一步处理这些异常,例如,发送通知或记录到日志文件中。 - 动态性:

虽然@Scheduled注解提供了一种静态的方式来定义定时任务,但 Spring 还提供了更高级的功能,如动态地创建和修改定时任务。这通常通过编程方式使用TaskScheduler接口来实现。

下面是一个简单的示例,展示了如何使用 @Scheduled 注解来创建一个定时任务:

1 | |

在这个例子中,reportCurrentTime 方法会被 Spring 每隔 5 秒调用一次,因为我们在 @Scheduled 注解中设置了 fixedRate = 5000(以毫秒为单位)。

总之,@Scheduled 注解提供了一种声明式的方式来创建和管理定时任务,使得开发者能够专注于业务逻辑,而无需过多关注任务的调度和执行细节。

TCP 三次握手 / 四次挥手扩展问题

TCP 连接三次握手的过程是怎样的?

TCP 是面向连接的协议,使用 TCP 前必须建立连接。

- 一开始,客户端和服务端都处于 CLOSE 状态。

- 服务端主动监听某端口,进入 LISTEN 状态。

- 客户端随机初始化序号(c1),即 TCP 报文首部的序号字段,同时把同步标志位置为 1,表示这是一个 TCP 连接请求报文。接着客户端把该报文发往服务端,表示向服务端发起连接,之后客户端进入同步已发送状态。

- 服务端收到客户端的 TCP 连接请求报文。

- 服务端首先初始化序号(s1),即 TCP 报文首部的序号字段;然后初始化确认应答号为 c1 + 1,表示该序号之前的内容全部接收完成,期望收到该序号之后的报文。同时把同步标志位和确认标志位置为 1,表示这是一个 TCP 连接响应报文。最后把该报文发往客户端,表示已收到并回应客户端的连接请求,之后服务端进入同步已接收状态。

- 客户端收到服务端的 TCP 连接响应报文。

- 客户端还要向服务端发送最后一个应答报文,这个报文是普通的 TCP 报文。客户端设置确认应答号为 s1 + 1,同时设置确认标志位为 1,表示这是一个普通的 TCP 应答报文。客户端把该报文发往服务端,这次报文可以携带客户端的数据到服务端,之后客户端进入已连接状态。

- 服务端收到客户端的应答报文后,也进入已连接状态。

一旦完成三次握手,双方都处于已连接状态,连接建立完成,客户端和服务端就可以相互发送数据了。

TCP 四次挥手的过程是怎样的?

双方都可以主动断开连接,以客户端主动断开连接为例。

- 客户端打算关闭连接,把终止标志位置为 1,表示这是一个连接终止请求报文。客户端把该报文发往服务端,进入终止等待 1 状态。

- 服务端收到该报文,向客户端发送普通的 TCP 应答报文,之后服务端进入关闭等待状态。

- 客户端收到服务端的应答报文,之后进入终止等待 2 状态。

- 等待服务端处理完数据,服务端再把终止标志位置为 1,向客户端发送连接终止请求报文,之后服务端进入最后等待状态。

- 客户端收到该报文,再次往服务端发送一个普通的 TCP 应答报文,之后客户端进入时间等待状态。

- 服务端收到该应答报文,之后进入关闭状态,至此服务端已经完成了连接的关闭。

- 客户端在经过 2MSL(最大报文存活时间)后,自动进入关闭状态,至此客户端也完成了连接的关闭。

JWT 原理

Session / Cookie

性能优化方案

代码层面的优化:

算法改进

- 选择更高效的算法来替代低效的算法。例如,使用快速排序替代冒泡排序,使用哈希表替代线性搜索等。

- 尽量减少时间复杂度较高的操作,如嵌套循环和递归调用。

数据结构选择

- 根据数据的特点和使用场景,选择合适的数据结构。例如,如果需要频繁地插入和删除元素,可以使用链表或哈希表;如果需要保持元素的顺序,可以使用数组或平衡二叉树。

- 避免不必要的数据结构转换和复制操作,以减少内存消耗和 CPU 时间。

代码精简与复用

- 移除冗余代码和重复逻辑,提高代码的可读性和可维护性。

- 使用函数和模块来封装重复使用的代码,减少代码的重复编写和调试工作。

系统层面的优化:

缓存策略

- 利用缓存技术来存储和复用频繁访问的数据,减少对数据库或远程服务的访问次数。

- 选择合适的缓存策略,如 LRU(最近最少使用)算法,来管理缓存空间,确保缓存中的数据是最有价值的。

并发控制

- 利用多线程或多进程技术,实现任务的并行处理,提高系统的吞吐量和响应速度。

- 使用合适的并发控制机制,如锁、信号量或条件变量,来避免并发访问导致的数据冲突和死锁问题。

网络优化

优化网络传输协议和参数设置,减少网络延迟和丢包率。

使用压缩算法对传输的数据进行压缩,减少网络带宽的占用。

数据库层面的优化:

索引设计

- 根据查询需求和表结构,设计合适的索引。选择具有高选择性的列作为索引键,以提高查询效率。

- 定期分析和优化索引的使用情况,避免索引失效或冗余索引导致的性能问题。

查询优化

- 优化 SQL 查询语句,减少不必要的 JOIN 操作、子查询和聚合函数的使用。

- 使用数据库提供的查询执行计划工具,分析查询的执行过程,找出性能瓶颈并进行优化。

分区与分片

- 对于大型数据库表,可以使用分区技术将数据分成多个部分,提高查询和管理效率。

- 在分布式数据库系统中,可以使用分片技术将数据分散到多个节点上,实现负载均衡和水平扩展。

数据库配置与参数调优

- 根据硬件环境和业务特点,调整数据库的配置参数,如缓冲区大小、连接池大小等,以获得最佳的性能表现。

- 监控数据库的性能指标,如响应时间、吞吐量、CPU 利用率等,及时发现和解决性能问题。

需要注意的是,性能优化是一个持续的过程,需要不断地对系统进行监控和分析,并根据实际情况进行调整和优化。同时,在优化过程中要权衡利弊,避免过度优化导致系统复杂性和维护成本的增加。

设计模式

什么是设计模式

设计模式是软件设计中常见的问题解决方案的归纳总结,是在特定情境下的经验性的解决方案。

它们被广泛接受和应用于软件开发中,旨在提高代码的可重用性、可维护性和灵活性。

七大原则

设计模式的七大原则是作为设计模式的基础准则,可以用来指导设计模式的选择和应用。这些原则是:

- 单一职责原则(SRP):一个类应该只有一个引起它变化的原因。

- 开放-封闭原则(OCP):软件实体(类、模块、函数等)应该对扩展是开放的,对修改是封闭的。

- 里氏替换原则(LSP):子类型必须能够替换其基类型,而不会影响程序的正确性。

- 接口隔离原则(ISP):建立最小的依赖,不要依赖不需要的接口。

- 依赖倒置原则(DIP):依赖于抽象,而不是具体实现。

- 迪米特法则(LoD):一个对象应该对其他对象保持最少的了解。

- 组合/聚合复用原则(CARP):优先使用组合和聚合,而不是继承。

分类

设计模式根据功能和用途可以分为三大分类:

- 创建型设计模式:这些模式关注对象的创建机制,主要包括工厂模式、抽象工厂模式、单例模式、原型模式和建造者模式等。

- 结构型设计模式:这些模式关注如何组合和使用对象,主要包括适配器模式、装饰器模式、代理模式、组合模式、享元模式和桥接模式等。

- 行为型设计模式:这些模式关注对象之间的通信和协作方式,主要包括策略模式、模板方法模式、观察者模式、迭代器模式、访问者模式、命令模式、备忘录模式、状态模式和解释器模式等。

这些分类和原则将设计模式划分到更具体的范畴,并提供了指导设计和实施设计模式的准则。理解和应用这些原则和分类有助于开发人员更好地使用设计模式来解决问题。

Maven

Maven 学习:

基础:Maven 的下载安装、IDEA 创建 Maven 项目,了解 Maven 项目结构

依赖管理:依赖坐标(GAV)、依赖范围管理、Maven 的工作原理、Maven 的生命周期

依赖冲突:依赖的传递性、自动解决依赖冲突、排除依赖

分模块开发:通过 mvn install 命令,将不同的 Maven 项目安装到本地仓库,其他工程就能通过 GAV 坐标引入该工程了。实现业务模块拆分,简化项目管理,提高代码复用性,方便团队协作

聚合工程:一个项目允许创建多个子模块,多个子模块组成一个整体,可以统一进行项目的构建。公共的依赖、配置、插件等,都可以配置在父工程里。父工程可以定义可选依赖<dependencyManagement>,该标签里的依赖项,子工程可选择使用。子工程可以使用<optional>true</optional>开启隐藏依赖,该依赖不会传递给其他工程。Maven聚合工程可以对所有子工程进行统一构建,而不需要像传统的分模块项目一样,需要挨个打包、测试、发布。

Maven 属性:在 <properties> 标签下,自定义属性(依赖版本,项目环境属性,Java 环境变量等)。

多环境配置:

多模块开发:

① 简化项目管理,拆成多个模块/子系统后,每个模块可以独立编译、打包、发布等;

② 提高代码复用性,不同模块间可以相互引用,可以建立公共模块,减少代码冗余度;

③ 方便团队协作,多人各司其职,负责不同的模块,Git管理时也能减少交叉冲突;

④ 构建管理度更高,更方便做持续集成,可以根据需要灵活配置整个项目的构建流程

巩固复习了 Maven,终于明白了 API 接口开放平台的运作原理。

Maven 是什么,Maven 是一个项目构建和管理工具,是 Apache 下的一个纯 Java 开发的开源项目,我们现在基本都在使用 Maven 来构建和管理 Java 项目,当然也有其他类似的的项目构建和管理工具,比如 Gradle。(2023/12/01 晚)

那么我们为什么要使用 Maven 呢?使用它有什么好处?我们首先要认识到,在没有使用 Maven 工具之前,项目构建和管理存在很多问题:

- 依赖关系管理困难:在手动构建项目时,需要手动下载和添加项目所需的依赖库,这不仅耗时而且容易出错。此外,如果项目中有多个模块,需要确保每个模块都有正确的依赖版本,这需要花费大量时间和精力。

- 构建过程繁琐:在没有自动化构建工具的情况下,开发人员需要手动编译、测试和打包项目。这不仅耗时,而且容易出错。此外,如果项目中有多个模块,需要分别构建每个模块,这会进一步增加构建的复杂性。

- 项目结构五花八门:在没有统一的项目构建和管理规范的情况下,每个项目可能会有自己独特的项目结构,这使得项目之间的协作和交流变得困难。

- 版本控制和发布困难:在没有 Maven 之前,版本控制和发布需要手动完成,这不仅耗时而且容易出错。此外,如果项目中有多个模块,需要分别发布每个模块,这会进一步增加发布的复杂性。

- 团队协作效率低下:在没有 Maven 之前,团队成员之间需要手动共享项目文件和依赖库,这不仅效率低下,而且容易出错。此外,如果项目中有多个模块,需要分别管理每个模块的代码和依赖库,这会进一步降低团队协作的效率。

总之,没有 Maven 之前,项目构建和管理可能会面临许多痛点,包括依赖关系管理困难、构建过程繁琐、项目结构五花八门、版本控制和发布困难以及团队协作效率低下等问题。而 Maven 等自动化构建工具的出现有效地解决了这些问题,提高了项目构建和管理的效率和准确性。

那么 Maven 项目的结构是怎样的呢?通常包括以下几个部分:

src:包含了项目所有的源代码和资源文件以及测试代码。其中 src/main/java 这个目录下储存 java 源代码,src/main/resources 储存主要的资源文件,比如 spring 的 xml 配置文件和 log4j 的 properties 文件,src/test/java 存放测试代码。target:编译后内容放置的文件夹。pom.xml:这是 Maven 的基础配置文件,也是 Maven 项目核心配置文件,相当关键,用于配置项目的基本信息、依赖范围管理、解决依赖冲突、实现分模块开发、多环境配置

其他相关的还有:Maven 的私服搭建、配置 Maven 镜像源、Maven 的生命周期

Mybatis 工作流程

加载配置文件:读取 MyBatis 的配置文件(mybatis-config.xml),包含全局配置信息:运行环境、数据库连接信息。加载映射文件,包含将要执行的 SQL 语句。

构建会话工厂:即创建 SqlSessionFactory:使用配置文件创建 SqlSessionFactory 对象,该对象负责创建创建会话对象 SqlSession。

创建会话对象,根据会话工厂 SqlSessionFactory 获取 SqlSession 对象,SqlSession 包含了执行 SQL 的所有方法,代表一次会话。

执行映射文件:使用会话对象 SqlSession ,根据 Mybatis 提供的 API(增删改查语句),执行映射文件中定义的 SQL 语句。

处理操作结果:解析传入的参数,构建最终要执行的 SQL 语句,获取数据库连接,执行 SQL,将 SQL 执行的结果进行转换,映射为 Java 对象或集合。

返回处理结果:释放与数据库的连接资源,关闭会话对象 SqlSession,返回最终的处理结果。

结合工作实践来讲,MyBatis 所具备的亮点可总结为如下三个方面。

第一,MyBatis 本身就是一款设计非常精良、架构设计非常清晰的持久层框架,并且 MyBatis 中还使用到了很多经典的设计模式,例如,工厂方法模式、适配器模式、装饰器模式、代理模式等。 在阅读 MyBatis 代码的时候,你也许会惊奇地发现:原来大师设计出来的代码真的是一种艺术。所以,从这个层面来讲,深入研究 MyBatis 原理,甚至阅读它的源码,不仅可以帮助你快速解决工作中遇到的 MyBatis 相关问题,还可以提高你的设计思维。

第二,MyBatis 提供了很多扩展点,例如,MyBatis 的插件机制、对第三方日志框架和第三方数据源的兼容等。 正由于这种可扩展的能力,让 MyBatis 的生命力非常旺盛,这也是很多 Java 开发人员将 MyBatis 作为自己首选 Java 持久化框架的原因之一,反过来促进了 MyBatis 用户的不断壮大。

第三,开发人员使用 MyBatis 上手会非常快,具有很强的易用性和可靠性。这也是 MyBatis 流行的一个很重要的原因。当你具备了 MySQL 和 JDBC 的基础知识之后,学习 MyBatis 的难度远远小于 Hibernate 等持久化框架。

什么是 Spring MVC?

MVC 是一种常用的软件设计思想,它将业务逻辑、数据模型和界面显示分离,使得代码更加清晰、可维护。

SpringMVC 是 Spring 框架中的一个重要模块,它基于 MVC(Model-View-Controller)设计模式,是一个用于构建 Web 应用程序的轻量级 Web 框架。

在 SpringMVC 中,Controller(控制器)负责处理用户请求并返回响应。

Model(模型)是数据的表示,它包含了应用程序的状态和业务逻辑。

View(视图)是用户界面的表示,它负责显示数据给用户。

Spring MVC 工作原理

客户端(浏览器)发送请求, DispatcherServlet拦截请求。

DispatcherServlet 根据请求信息调用 HandlerMapping 。HandlerMapping 根据 URL 去匹配查找能处理的 Handler(也就是我们平常说的 Controller 控制器) ,并会将请求涉及到的拦截器和 Handler 一起封装。

DispatcherServlet 调用 HandlerAdapter适配器执行 Handler 。

Handler 完成对用户请求的处理后,会返回一个 ModelAndView 对象给DispatcherServlet,ModelAndView 顾名思义,包含了数据模型以及相应的视图的信息。Model 是返回的数据对象,View 是个逻辑上的 View。

ViewResolver 会根据逻辑 View 查找实际的 View。

DispaterServlet 把返回的 Model 传给 View(视图渲染)。

把 View 返回给请求者(浏览器)。

当用户发送请求到 Web 服务器时,SpringMVC 的 DispatcherServlet(前端控制器)会拦截这些请求,HandlerMapping(处理映射器)根据请求的 URL 映射 / 匹配查找能处理的 Handler(也就是我们平常说的 Controller 控制器),并调用 HandlerAdapter(处理适配器)执行相应的 Controller。Controller 会调用业务逻辑层(通常是 Service 层)来处理请求,获取相应的数据,然后将数据传递给 Model。Model 将数据传递给 View 进行渲染;最后,View 将渲染结果返回给用户。

总的来说,SpringMVC 通过 MVC 设计模式将 Web 应用程序的不同部分进行分离,使得代码更加清晰、可维护,提高了开发效率。同时,SpringMVC 还提供了丰富的功能和特性,如数据绑定、异常处理、拦截器等,帮助开发人员更好地构建 Web 应用程序。

RequestMapping

在 SpringMVC 中,@RequestMapping是一个用于映射 Web 请求到特定处理器函数(通常是 Controller 中的方法)的注解。它可以定义 URL 路径、HTTP 请求方法(GET、POST 等)、请求头、请求参数等,使得 Controller 能够处理特定的请求。

请求控制器

请求控制器在 SpringMVC 中通常指的是 Controller 类及其中的方法。它们负责处理用户的请求,调用业务逻辑,并返回视图或数据。Controller 是 MVC 模式中的 C 部分,负责接收请求和发送响应。

拦截器

拦截器(Interceptor)在 SpringMVC 中用于在请求处理过程中拦截用户的请求和响应,可以在请求到达 Controller 之前或响应返回给用户之前执行一些预处理或后处理操作。例如,可以用来进行权限验证、日志记录、性能监控等。

请求参数封装

在 SpringMVC 中,请求参数可以自动封装到 Controller 方法的参数中。SpringMVC 利用参数绑定机制,可以将请求中的参数(如 GET 请求的查询参数、POST 请求的请求体等)自动绑定到 JavaBean、Map 或其他数据类型中,简化了参数的获取和处理。

请求过滤器

请求过滤器(Filter)是 Servlet 规范中的一部分,与 SpringMVC 不完全相关,但经常在 Java Web 应用程序中使用。过滤器可以在请求到达 Servlet 容器中的任何资源之前或之后执行代码。它们常用于处理编码问题、记录日志、压缩响应、身份验证等。

全局异常处理

在 SpringMVC 中,可以通过实现HandlerExceptionResolver接口或使用@ControllerAdvice和@ExceptionHandler注解来全局处理异常。这样,当 Controller 中的方法抛出异常时,可以统一捕获和处理这些异常,避免在 Controller 中分散处理异常代码,提高了代码的可维护性。

RestFul 风格

RestFul 风格是一种 Web 服务的设计和开发方式,它强调资源的表示、状态转移和 HTTP 方法的正确使用。在 RestFul 风格的 Web 服务中,每个 URL 代表一个资源,不同的 HTTP 方法(GET、POST、PUT、DELETE 等)用于操作这些资源。这种设计方式使得 Web 服务更加简洁、直观和易于理解。

JSON 框架

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式。在 Java Web 应用程序中,常用的 JSON 框架有 Jackson、Gson 等。这些框架可以帮助 Java 应用程序将 Java 对象转换为 JSON 格式的字符串,或者将 JSON 格式的字符串转换为 Java 对象,从而方便地与前端进行数据交换。

Bean 的生命周期

简单总结 Spring Bean 生命周期流程:

- 实例化:启动 Spring 应用,IOC 容器为所有已声明的 Bean 创建一个实例

- 属性赋值:实例化后,Spring 通过反射机制给 Bean 的属性赋值

- 调用 Bean 的初始化方法:调用 Bean 配置的

@PostConstruct、afterPropertiesSet方法或者init-method指定的方法 - Bean 运行期:Bean 已经准备好被程序使用了,它已经被初始化并赋值完成

- Bean 销毁:当容器关闭时,调用

Bean的销毁方法

Spring 的启动流程

Spring 的启动流程大致有以下几个关键步骤:

加载配置文件:Spring 在启动时,首先加载其 XML 格式的配置文件,配置文件中定义了 Spirng 容器中管理的 Bean 属性以及依赖关系。

解析配置文件:加载完配置文件,由 XML 解析器将将配置文件中的 Bean 定义转化为 Spring 容器可以理解和使用的内部数据结构。

创建并初始化 Bean:根据解析得到的 Bean 定义,Spring 开始创建相应的 Bean 实例,进行初始化,包括设置属性值、处理依赖关系。

注册 Bean:Bean 初始化完成会被注册到 Spring 容器中,其他 Bean 就可以通过容器获取这些 Bean 引用进行使用,这就是依赖注入。

至此,当所有的 Bean 都创建并初始化完成后,Spring 启动完成,可以对外提供服务了。

Spring Boot 的启动流程跟 Spring 的启动流程在核心逻辑上基本上是一致的,但存在一些差异:

自动化配置:传统的 Spring 应用程序,需要在 appicationContext.xml 或者 mybatis-config,xml 中手动配置数据源,包括数据库 URL、用户名、密码等,很繁琐。而 Spring Boot 提供了自动配置功能:导入 jar 包依赖,在 resource 下的 yaml / properties 配置文件里简单地写清楚配置。Spring Boot 就会自动创建已经配置好的数据源 Bean,不再需要手动配置数据源。

简化依赖管理:Spring Boot 提供了一系列 starter 依赖,只需要在项目中引入 starter 依赖,Spring Boot 便会自动引入所需的库。不再需要自己处理复杂的依赖关系,比如解决依赖冲突、版本兼容等问题,大大简化了依赖管理。

内嵌服务器:不同于 Spring 需要开发者手动配置和部署 Web 服务器。Spring Boot 内嵌了常用的 Web 服务器(如 Tomcat、Jetty 等),使得开发者无需单独配置和部署 Web 服务器。只需导入 jar 包依赖(GAV 坐标),在 resource 的 yaml / properties 配置文件中指定监听端口,在启动 Spring Boot 应用程序时,内置服务器就会自动启动并监听相应的端口。

快速启动:由于 Spring Boot 的自动化配置、简化依赖管理、内嵌服务器等,只需要直接运行 @SpringBootApplication 标注的启动类,就可以一键启动 Spring Boot 应用程序。

简化部署:通过一行命令:java -jar 等即可快速将 Spring Boot 应用程序打包成一个可执行的 JAR 或 WAR 文件。再将打包好的文件复制到目标服务器上,通过一行命令就可以一键启动,部署变得十分简单和方便。

Spring 自动配置原理

Starter 依赖,集成第三方,启动类,扫描并加载所在包以及子包的 Bean,开启自动配置功能,发现并加载自动配置类,根据条件注解等,实现自动装配。

@SpringApplication是 Spring Boot 的核心注解,它包含了@SpringBootConfiguration、@EnableAutoConfiguration和@ComponentScan等注解。

@SpringBootConfiguration:声明当前类是配置类,允许使用@Bean注解定义 bean。@EnableAutoConfiguration:根据项目的依赖关系,自动配置 Spring Boot 项目。@ComponentScan:让 Spring 扫描到 Configuration 类并把它加入到程序上下文。

SpringBoot 的自动装配原理主要基于 Spring 框架的依赖注入和条件化 Bean 机制,并结合 SpringBoot 的特定功能和设计原则实现的。

首先,SpringBoot 通过引入一系列 starter 依赖,使得开发者能够便捷地集成各种第三方库和框架。每个 starter 都包含了一系列预定义的配置和 Bean 定义,用于简化特定功能的集成过程。

在 SpringBoot 应用启动时,@SpringBootApplication注解起到了关键作用。这个注解实际上是一个复合注解,其中@EnableAutoConfiguration是实现自动装配的核心。它告诉 SpringBoot 开启自动配置功能。

SpringBoot 的自动配置功能通过加载META-INF/spring.factories文件来发现并加载各种自动配置类。这些自动配置类使用条件注解(如@ConditionalOnClass、@ConditionalOnProperty等)来确定是否应该创建和配置特定的 Bean。条件注解允许根据类路径、属性设置、Bean 是否存在等条件来启用或禁用自动配置。

当 SpringBoot 启动时,它会扫描这些自动配置类,并根据条件注解的判断来决定是否创建和注册相应的 Bean 到 Spring 容器中。如果某个自动配置类满足其条件注解指定的条件,那么它定义的 Bean 就会被创建并注入到 Spring 容器中,从而完成自动装配过程。

除了自动配置类,SpringBoot 还利用了一些核心组件来实现自动装配,如AutoConfigurationImportSelector和SpringFactoriesLoader。AutoConfigurationImportSelector负责从spring.factories中加载自动配置类,并根据条件进行筛选。SpringFactoriesLoader则用于加载META-INF/spring.factories文件中定义的配置。

通过这种方式,SpringBoot 能够自动配置应用的很多方面,如数据库连接、消息队列、Web 服务等,从而大大简化了开发者的配置工作,提高了开发效率。

需要注意的是,虽然自动装配能够极大地简化配置工作,但在某些情况下,开发者仍然需要手动配置一些 Bean 或覆盖自动配置的默认设置,以满足特定的业务需求。因此,理解 SpringBoot 的自动装配原理并熟悉其配置方式,对于开发者来说是非常重要的。

Spring 的扩展点

API 项目介绍

API 项目介绍:分为四个模块:api-core,实现用户管理、接口管理、接口调用等;api-gateway,做统一的访问控制、流量染色、用户鉴权,完成统一登录校验、API 签名校验、接口调用统计和请求响应前后的日志处理;api-client,自主设计对外提供接口服务;api-common,抽象公共接口 / 方法、公共实体类。

使用 Maven 聚合工程管理子模块,都需要在本地 install。接口调用的逻辑:请求 api-core 的接口调用服务:首先校验参数,判断接口是否存在。获取当前登录用户,拿到 ak 和 sk,以此作为参数构建 SDK 客户端。SDK 客户端通过封装请求参数(包含用户信息、调用接口信息),使用 Hutool 工具包,发送请求到网关。

网关实现全局过滤,获取请求头的一切信息:请求参数、请求路径、请求来源地址等。做 API 签名校验,鉴定用户身份;根据请求路路径和方法判断接口状态,是否存在,是否发布或下线;设置 ip 黑白名单,只允许当前服务器的请求可以通过;流量染色,给请求添加统一的请求头。完成一系列校验之后,将该合法请求转发给真正的接口服务,处理接口调用,返回响应。最后在 haddleReponse 响应处理器中,完成接口调用统计等业务逻辑,更新相关字段,比如用户剩余调用次数、接口调用总次数等。返回响应,结束整个调用流程。

不希望引入复杂的业务逻辑,为减小网关模块体量,遵循单一原则,抽象公共业务逻辑和公共实体类到 api-common 模块。引入 Dubbo 轻量的 RPC 框架,用 EnabbleDubbo、@DubboReference、@DubboServie 等,使用 Nacos 做注册中心,实现服务注册。网关服务作为消费者实现服务拉取。实现服务间方法调用。

微服务架构

从单体应用迁移到微服务架构:

单体应用线上发布和部署效率低下、团队协作开发成本高、系统可用性差。

相较于单体应用,微服务实现了更细粒度的服务拆分、更高效的服务部署和独立维护、提供了更清晰的服务治理方案。

要实现从单体应用迁移到微服务架构,就要做好服务化拆分,设计服务间调用。明确微服务架构的基本组件:服务描述、注册中心、服务框架、服务监控、服务追踪、服务治理。

CAP 理论

- CAP 定理指出,一个分布式系统不可能同时满足一致性(Consistency)、可用性(Availability)和分区容错性(Partition tolerance)这三个基本需求。

- 在设计分布式系统时,需要根据实际需求权衡这三个属性。

- 大多数分布式系统会选择牺牲一致性(CP)或可用性(AP)来满足分区容错性。

CAP 理论是分布式系统设计中的一个基本原则,它涉及的是在一个分布式系统中,Consistency(一致性)、Availability(可用性)和 Partition Tolerance(分区容错性)这三个目标之间的关系。CAP 理论断言,在一个分布式系统中,最多只能同时满足其中的两个目标,而无法同时满足三个。

具体来说,一致性要求分布式系统中的所有数据备份在同一时刻具有相同的值。可用性则意味着在集群中一部分节点故障后,集群整体仍然能够响应客户端的读写请求,即系统提供的服务必须一直处于可用的状态,对于用户的每一个操作请求总是能够在有限的时间内返回结果。分区容错性则是指分布式系统虽然由多个节点组成,但对外应该表现为一个整体,即使内部某个节点或网络出现故障,系统对外也不应出现异常。

根据 CAP 理论,存在两种常见的模式供系统设计者选择:CP 模式和 AP 模式。在 CP 模式下,系统会优先保证数据的一致性和分区容错性,这意味着在网络分区发生时,系统可能会拒绝部分请求以确保数据的一致性。这种模式适用于对数据一致性要求较高的场景,如金融系统。而在 AP 模式下,系统则会优先保证可用性和分区容错性,即使在网络分区发生时,系统仍然可以接受请求并提供部分功能,这种模式适用于对可用性要求较高的场景。

因此,在设计分布式系统时,需要根据实际应用场景和需求来权衡这三个目标,从而选择适合的 CAP 策略。

服务发布和引用

注册中心(服务注册和发现)

在微服务架构下,主要有三种角色:服务提供者(RPC Server)、服务消费者(RPC Client)和服务注册中心(Registry),三者的交互关系请看下面这张图,我来简单解释一下。

RPC Server 提供服务,在启动时,根据服务发布文件 server.xml 中的配置的信息,向 Registry 注册自身服务,并向 Registry 定期发送心跳汇报存活状态。

RPC Client 调用服务,在启动时,根据服务引用文件 client.xml 中配置的信息,向 Registry 订阅服务,把 Registry 返回的服务节点列表缓存在本地内存中,并与 RPC Sever 建立连接。

当 RPC Server 节点发生变更时,Registry 会同步变更,RPC Client 感知后会刷新本地内存中缓存的服务节点列表。

RPC Client 从本地缓存的服务节点列表中,基于负载均衡算法选择一台 RPC Sever 发起调用。

RPC 调用

想要完成 RPC 调用,你需要解决四个问题:

- 客户端和服务端如何建立网络连接?

- 服务端如何处理请求?(选择合适的通信框架比如 Netty,解决客户端与服务端如何建立连接、管理连接以及服务端如何处理请求的问题)

- 数据传输采用什么协议?(选择合适的通信协议比如 HTTP,解决客户端和服务端采用哪种数据传输协议的问题)

- 数据该如何序列化和反序列化?(多种序列化格式比如 Java 原生序列化、JSON、XML、Thrift,解决客户端和服务端采用哪种数据编解码的问题)

Socket 通信

Socket 通信是基于 TCP/IP 协议的封装,建立一次 Socket 连接至少需要一对套接字,其中一个运行于客户端,称为 ClientSocket ;另一个运行于服务器端,称为 ServerSocket 。就像下图所描述的,Socket 通信的过程分为四个步骤:服务器监听、客户端请求、连接确认、数据传输。

- 服务器监听:ServerSocket 通过调用 bind()函数绑定某个具体端口,然后调用 listen()函数实时监控网络状态,等待客户端的连接请求。

- 客户端请求:ClientSocket 调用 connect()函数向 ServerSocket 绑定的地址和端口发起连接请求。

- 服务端连接确认:当 ServerSocket 监听到或者接收到 ClientSocket 的连接请求时,调用 accept()函数响应 ClientSocket 的请求,同客户端建立连接。

- 数据传输:当 ClientSocket 和 ServerSocket 建立连接后,ClientSocket 调用 send()函数,ServerSocket 调用 receive()函数,ServerSocket 处理完请求后,调用 send()函数,ClientSocket 调用 receive()函数,就可以得到得到返回结果。

服务监控

服务监控主要包括四个流程:数据采集、数据传输、数据处理和数据展示

监控对象有用户端监控、接口监控、资源监控、基础监控,监控指标有请求量、响应时间和错误率

服务追踪

在微服务架构下,由于进行了服务拆分,一次请求往往需要涉及多个服务,每个服务可能是由不同的团队开发,使用了不同的编程语言,还有可能部署在不同的机器上,分布在不同的数据中心。

如果有一个系统,可以跟踪记录一次用户请求都发起了哪些调用,经过哪些服务处理,并且记录每一次调用所涉及的服务的详细信息,这时候如果发生调用失败,你就可以通过这个日志快速定位是在哪个环节出了问题,这个系统就是今天我要讲解的服务追踪系统。

服务治理

在一次服务调用过程中,服务提供者、服务消费者、注册中心、网络都有可能出问题。我们要尽可能保证服务调用成功,这就是服务治理。

服务治理可以从很多方面考虑:

- 从服务健康状态考虑。要做到服务节点管理,比如使用心跳检测机制,这种机制要求服务提供者定时的主动向注册中心汇报心跳

- 从服务节点访问优先级考虑。一般情况下,服务提供者节点不是唯一的,多是以集群的方式存在。要选择合适的负载均衡策略,充分利用机器的性能。

- 从调用的健康状态考虑。服务调用并不总是一定成功的,对于服务调用失败的情况,需要有手段自动恢复,来保证调用成功。

Dubbo 的工作原理

Dubbo 框架的工作原理主要基于服务注册与发现、远程调用、负载均衡以及服务监控等核心机制。以下是 Dubbo 框架工作原理的详细解释:

- 服务注册与发现:

- 服务提供者(Provider)在启动时,会将自己提供的服务接口信息注册到注册中心(Registry)。注册中心是一个服务目录框架,用于服务的注册和服务事件的发布和订阅。

- 服务消费者(Consumer)在启动时,会向注册中心订阅自己所需的服务。注册中心会返回服务提供者地址列表给消费者。如果服务提供者地址列表有变更,注册中心会基于长连接推送变更数据给消费者。

- 远程调用:

- Dubbo 采用了代理机制来实现远程调用。服务消费者通过代理对象来调用远程服务,而代理对象会负责将调用请求序列化为网络传输格式,并通过网络通信框架发送给服务提供者。

- 服务提供者接收到请求后,会进行反序列化,并执行相应的服务逻辑。执行结果同样会被序列化为网络传输格式,并返回给服务消费者。

- 负载均衡:

- Dubbo 提供了多种负载均衡策略,如随机、轮询、一致性哈希等。服务消费者在调用远程服务时,会根据负载均衡策略从服务提供者地址列表中选择一个合适的服务提供者进行调用。

- 如果调用失败,服务消费者可以根据配置选择重试或切换到其他服务提供者。

- 服务监控:

- Dubbo 提供了服务监控中心(Monitor),用于统计服务的调用次数、调用时间等日志信息。服务提供者和消费者在内存中累计调用次数和调用时间,并定时发送统计数据到监控中心。

- 监控中心可以对这些数据进行分析和可视化展示,帮助开发人员了解服务的运行状况,并进行性能调优和故障排查。

总的来说,Dubbo 框架通过注册中心实现了服务的动态注册与发现,通过代理机制实现了远程调用的透明化,通过负载均衡策略保证了服务的可用性和性能,通过监控中心提供了服务的运行状况分析和优化手段。这些机制共同构成了 Dubbo 框架的核心工作原理,使得分布式系统中的服务调用更加高效、可靠和易于管理。

Dubbo 是一个高性能、轻量级的开源 Java RPC 框架,主要用于服务之间的远程调用。其实现原理和流程如下:

实现原理:

- 代理机制:Dubbo 通过 Java 的动态代理或 CGLIB 代理生成服务消费者端的代理对象。当消费者调用服务时,实际上是调用这个代理对象。

- 注册中心:服务提供者将服务注册到注册中心(如 Zookeeper、Nacos 等),服务消费者从注册中心订阅所需的服务。注册中心负责服务的发现和通知。

- 序列化与反序列化:Dubbo 使用特定的序列化协议(如 Hessian2、Kryo 等)将请求和响应数据进行序列化和反序列化,以便在网络中传输。

- 通信协议:Dubbo 定义了自己的通信协议,包括请求头、请求体等结构,用于服务提供者和消费者之间的通信。

流程:

- 服务提供者启动时,将服务注册到注册中心。

- 服务消费者启动时,向注册中心订阅所需的服务。

- 注册中心通知消费者可用的服务提供者列表。

- 消费者通过负载均衡策略选择一个提供者,并通过代理对象发起远程调用。

- 代理对象将调用请求序列化后发送给选定的提供者。

- 提供者接收到请求后,进行反序列化,并执行相应的服务逻辑。

- 提供者将执行结果序列化后返回给消费者。

- 消费者接收到结果后,进行反序列化,并返回给调用方。

为什么可以调用到对应服务:

Dubbo 通过注册中心实现了服务的动态发现和注册,使得服务消费者能够知道哪些服务提供者是可用的。同时,Dubbo 的代理机制和通信协议使得消费者能够通过网络调用远程服务提供者。这种机制保证了服务的透明性和可扩展性,使得消费者无需关心服务的具体位置和实现细节,只需关注服务接口即可。

Dubbo 是一个高性能、轻量级的开源 Java RPC 框架。它的核心作用是实现远程服务调用,即在不同的进程或机器之间进行通信。Dubbo 采用了服务提供者和服务消费者的角色划分,通过注册中心进行服务的注册与发现。服务提供者将服务接口实现暴露出来,并注册到注册中心;服务消费者从注册中心获取服务提供者的地址列表,然后通过代理对象调用远程服务。Dubbo 支持多种通信协议和序列化方式,可以根据不同的场景选择合适的配置。

在使用 Dubbo 时,我会先定义服务接口,并在服务提供者中实现该接口。然后,在 Dubbo 的配置文件中指定服务接口的实现类、注册中心地址等信息。服务提供者启动后,Dubbo 会自动将服务注册到注册中心。在服务消费者端,我只需要引入服务提供者的接口依赖,并在 Dubbo 的配置文件中指定所需服务的名称和注册中心地址。Dubbo 会为我们生成代理对象,通过该对象就可以像调用本地方法一样调用远程服务。

Nacos 工作原理

Nacos 的核心运作原理主要围绕服务注册与发现、配置管理、服务管理以及集群管理展开。

首先,服务注册与发现。当服务提供者启动时,它会将自身的服务信息,如 IP 地址、端口号、服务名称等,注册到 Nacos 平台。而服务消费者则通过订阅或轮询的方式,从 Nacos 平台获取可用的服务列表,以便在需要时调用这些服务。这样,服务提供者和服务消费者就可以实现动态的关联和通信。

其次,配置管理。Nacos 提供了一个集中式的配置中心,开发人员可以将各种配置信息,如数据库连接信息、系统参数等,存储在这个中心化的配置中心中。服务消费者可以实时地从配置中心获取最新的配置信息,而无需重启应用程序。这大大提高了系统的灵活性和可维护性。

再者,服务管理。Nacos 提供了丰富的服务管理功能,包括服务的启停、监控、日志查看等。开发人员可以通过 Nacos 的界面或 API 对服务进行实时的管理和控制,确保服务的稳定运行。

最后,集群管理。Nacos 支持服务的集群管理,通过负载均衡、容错和故障转移等机制,确保服务的可用性和可靠性。即使部分服务节点出现故障,Nacos 也能自动调整服务调用策略,确保服务的连续性和稳定性。

总的来说,Nacos 通过集中式的服务注册与发现、配置管理、服务管理以及集群管理等功能,为分布式系统提供了一套高效、稳定且易于管理的解决方案。这使得开发人员能够更专注于业务逻辑的实现,而无需过多关注服务的部署、管理和维护等琐碎事务。

首先,Nacos 是一个更易于构建云原生应用的动态服务发现、配置管理和服务管理平台。它的注册中心功能主要实现了服务的注册与发现。当服务提供者启动时,它会将自己的服务信息注册到 Nacos 注册中心;服务消费者启动时,会从 Nacos 注册中心获取所需服务提供者的地址列表。这样,服务消费者就可以通过负载均衡策略选择一个服务提供者进行通信。同时,Nacos 还支持服务的健康检查、服务上下线通知等功能,以确保服务的可用性和稳定性。

在实际使用中,我会根据项目的需求配置 Nacos 服务端的地址和端口,然后在服务提供者和消费者中引入 Nacos 的客户端依赖。在服务提供者中,我会配置服务名称、版本等信息,并启动服务注册。在服务消费者中,我会配置所需服务的名称和版本,然后启动服务发现。通过 Nacos 的 API,我可以方便地获取服务提供者的地址列表,并进行负载均衡调用。

通过结合使用 Nacos 注册中心和 Dubbo RPC 框架,我能够构建出高效、稳定且易于扩展的分布式系统。在实际项目中,我会根据业务需求进行配置和优化,确保服务的性能和可靠性。同时,我也会关注相关的技术动态和最佳实践,不断学习和提升自己的能力。

希望以上回答能够满足您的要求,如果有进一步的问题或需要更多的细节,请随时提问。

Elasticsearch

什么是 Elasticsearch?

Elasticsearch 是一个基于 Lucene 构建的开源、分布式、RESTful 搜索引擎。它设计用于云计算中,能够达到实时搜索,稳定,可靠,快速,安装使用方便。

Elasticsearch 的运作原理主要基于以下几个关键概念:

- 节点与集群:每个节点是一个运行在单个机器上的独立的 Elasticsearch 实例。集群中的节点通过互相通信和协调工作来实现数据的分布式存储和搜索。这种分布式的架构使得 Elasticsearch 能够处理大规模的数据集,并提供高可用性和容错能力。

- 索引与文档:在 Elasticsearch 中,索引是逻辑上相关的文档集合,类似于关系数据库中的数据库。文档是可以被索引和搜索的基本信息单位,它由一组字段组成,每个字段包含一个数据值。文档使用 JSON 格式表示,可以包含各种字段的复杂结构。

- 分片与副本:为了支持横向扩展和处理大规模数据集,Elasticsearch 将索引分割成多个分片。每个分片是一个独立的索引,可以分布在不同的节点上。分片可以并行处理搜索请求,并在集群中进行负载均衡。此外,为了数据的冗余备份和故障恢复,Elasticsearch 还提供了副本机制,副本分布在不同的节点上,确保数据的可靠性和高可用性。

- 倒排索引:Elasticsearch 使用倒排索引来加速搜索过程。倒排索引与传统的正向索引不同,它不是按照文档的 ID 来建立索引,而是以词为单位,记录每个词在哪些文档中出现以及出现的位置等信息。这样,当用户进行搜索时,Elasticsearch 可以快速定位到包含相关词的文档,并返回结果。

在运作过程中,用户将数据提交到 Elasticsearch 数据库中,数据首先经过分词控制器进行分词处理,然后将分词结果和权重信息存入倒排索引中。当用户发起搜索请求时,Elasticsearch 根据倒排索引快速定位到相关文档,并根据权重进行排名和打分,最终将结果呈现给用户。由于 Elasticsearch 采用了近实时搜索技术,从建立索引到索引可以被搜索之间的延迟通常很小,通常是 1 秒左右,这使得 Elasticsearch 能够满足实时搜索的需求。

总的来说,Elasticsearch 通过分布式架构、倒排索引以及实时搜索等技术,实现了高效、可靠的大规模数据搜索和处理能力。

Elasticsearch 的运作原理

首先,我们要理解 Elasticsearch 的基本架构和核心概念。Elasticsearch 是一个基于 Lucene 构建的分布式搜索和分析引擎,它的核心是由多个节点组成的集群,每个节点上运行着 Elasticsearch 的实例。

数据写入过程:

- 创建索引:在 Elasticsearch 中,索引是一个包含多个文档的集合。当我们需要存储数据时,首先会定义一个索引,并为它配置相应的设置和映射。

- 写入文档:向 Elasticsearch 写入数据是通过发送 HTTP 请求来实现的,通常是将 JSON 格式的文档发送到指定的索引中。每个文档都有一个唯一的 ID,用于在索引中标识它。

- 分词与倒排索引:当文档被写入 Elasticsearch 时,它首先会通过分词器进行分词处理。分词器将文档中的文本分解成单独的词或词组(称为词条)。然后,Elasticsearch 为每个词条创建倒排索引。倒排索引是一个数据结构,它记录了每个词条在哪些文档中出现,以及出现的位置和频率等信息。这样,当执行搜索查询时,Elasticsearch 可以快速定位到包含相关词条的文档。

搜索查询过程:

- 发送查询请求:用户通过发送 HTTP 请求来执行搜索查询。查询请求可以包含各种条件,如关键词、范围、过滤器等。

- 解析查询:Elasticsearch 接收到查询请求后,会解析查询语句,将其转换为内部可执行的查询对象。

- 搜索倒排索引:Elasticsearch 使用解析后的查询对象在倒排索引中进行搜索。它会查找与查询条件匹配的词条,并获取包含这些词条的文档列表。

- 排序与评分:根据查询条件,Elasticsearch 会对文档进行排序和评分。排序可以根据字段的值进行升序或降序排列,而评分则基于文档与查询的匹配程度进行计算。

- 返回结果:最后,Elasticsearch 将搜索结果的文档列表返回给用户。这个结果列表通常包含文档的 ID、字段值以及评分等信息。

在整个过程中,Elasticsearch 的分布式架构发挥了重要作用。通过将索引分成多个分片,并在集群中的不同节点上进行存储和查询,Elasticsearch 能够实现水平扩展,处理大规模的数据集。同时,通过复制分片到不同的节点,Elasticsearch 还提供了高可用性和容错能力,确保数据的可靠性和稳定性。

此外,Elasticsearch 还支持实时搜索和近实时搜索。实时搜索意味着在文档被写入后立即就可以进行搜索,而近实时搜索则允许在文档写入后有极短的延迟时间(通常是几百毫秒到几秒)后进行搜索。这种实时或近实时的能力使得 Elasticsearch 非常适合于需要快速响应的搜索和分析场景。

总结来说,Elasticsearch 通过分词、倒排索引、分布式存储和查询等技术,实现了高效、可靠的大规模数据搜索和分析功能。

RabbitMQ 消息队列

RabbitMQ 实现消息队列的功能,主要依赖于其内部的几个核心组件以及它们之间的交互。以下是 RabbitMQ 实现消息传递的基本过程:

- 生产者(Producer)与交换机(Exchange)

- 生产者负责创建并发送消息。这些消息不是直接发送到队列,而是首先发送到交换机。

- 交换机负责接收来自生产者的消息,并根据其类型、路由键(Routing Key)或其他属性来决定这些消息应该发送到哪些队列。RabbitMQ 支持多种类型的交换机,如直接交换机、主题交换机等,每种类型都有其特定的路由逻辑。

- 队列(Queue)

- 队列是存储消息的容器。交换机根据路由规则将消息发送到相应的队列。

- 队列是持久的,即使 RabbitMQ 服务器重启,队列中的消息也不会丢失(当然,这取决于队列和消息的持久化设置)。

- 消费者(Consumer)

- 消费者是从队列中接收并处理消息的程序。

- 消费者通过订阅队列来接收消息。一旦有消息到达队列,且消费者处于活跃状态,消息就会被传递给消费者进行处理。

- 绑定(Binding)

- 绑定是交换机和队列之间的连接关系。它定义了交换机如何将消息路由到队列。

- 通过定义绑定,可以实现灵活的路由策略,使得消息能够按照预期的方式流动。

- 确认机制(Acknowledgment)

- 为了确保消息的可靠传递,RabbitMQ 提供了消息确认机制。当消费者成功处理一条消息后,它会发送一个确认信号给 RabbitMQ,RabbitMQ 收到确认后才会从队列中删除该消息。

- 如果消费者在处理消息时失败或崩溃,而没有发送确认信号,RabbitMQ 会认为该消息没有被成功处理,并重新将其放回队列以供其他消费者处理。

- 持久化(Persistence)

- 为了确保在 RabbitMQ 服务器故障时不会丢失数据,可以将交换机、队列和消息标记为持久的。这样,即使服务器重启,这些数据也会被保留下来。

综上所述,RabbitMQ 通过交换机、队列、消费者、绑定、确认机制和持久化等功能,实现了消息的可靠传递和系统的解耦。这使得 RabbitMQ 成为一个强大且灵活的消息队列系统,广泛应用于各种分布式系统和微服务架构中。

项目扩展思考

2024 年 2 月 20 日

正如标题所说,这个栏目就暂时放置一些我在逐步完善 MemorySearch 忆搜阁 项目过程中的扩展思考,为后续的学习提供思路:

ES 删除策略

Elasticseach 数据存储在硬盘内,如何选择合适的删除策略,清理过期数据呢

Elasticsearch 一个索引内可以存放的数据条数并没有固定的上限,它主要取决于以下几个因素:

- 磁盘空间:索引的大小受限于可用磁盘空间。Elasticsearch 会将索引数据存储在磁盘上,因此磁盘空间是限制索引大小的主要因素。

- 分片配置:Elasticsearch 通过分片(shards)来水平扩展数据,每个索引可以包含一个或多个分片。默认情况下,一个索引会有 5 个主分片(primary shards),但可以在创建索引时指定不同的分片数。分片数越多,索引可以容纳的数据量就越大,但同时也会增加集群的管理复杂性。

- 文档大小:单个文档的大小也会影响索引的容量。虽然 Elasticsearch 支持非常大的文档,但过大的文档可能会降低写入性能并增加索引的存储需求。

当索引达到其存储限制时,Elasticsearch 不会直接拒绝新的数据写入。相反,它会根据配置的策略来处理这种情况。常见的删除策略包括:

- 基于时间的删除:使用索引生命周期管理(ILM)策略,根据时间戳字段自动删除旧数据。例如,可以设置一个策略,使得索引在创建后的一定时间后被删除。

- 基于大小的删除:当索引达到一定的大小时,可以配置 ILM 策略来删除旧数据,或者通过手动干预来删除不需要的数据。

- 基于文档数量的删除:虽然 Elasticsearch 不直接基于文档数量限制索引大小,但可以通过删除旧文档来管理索引的大小。这可以通过编写删除查询或使用 ILM 策略来实现。

- 滚动索引:在某些场景中,可以使用滚动索引(rolling indices)模式,即定期创建新的索引来存储新数据,而旧索引可以被删除或归档。这种策略常见于日志收集和分析场景。

在实际应用中,建议根据业务需求和数据特点来选择合适的删除策略。同时,监控 Elasticsearch 集群的健康状况和性能,确保数据的有效管理和系统的稳定运行。

Elasticsearch 默认不提供自动删除旧数据的策略。默认情况下,索引会一直存在,直到你手动删除它们或者磁盘空间耗尽。但是,Elasticsearch 提供了索引生命周期管理(ILM)功能,允许你定义自己的删除策略。

当你创建一个索引时,除非你明确指定了 ILM 策略,否则该索引不会受到任何自动删除策略的影响。这意味着你需要主动管理索引的生命周期,包括决定何时删除不再需要的索引。

在 ILM 中,你可以定义策略来根据索引的年龄、大小或其他条件自动将索引移动到只读状态,并最终删除它们。但是,如果你不配置 ILM 或使用默认的 ILM 策略,索引将不会自动被删除。

因此,为了有效地管理 Elasticsearch 中的索引和数据,建议配置适当的 ILM 策略,以确保旧数据在不再需要时被自动删除,从而释放磁盘空间并优化集群性能。

确保 ES 文档的 id 唯一性

如何确保 Elasticsearch 文档的 id 唯一性?

在 Elasticsearch 中记录搜索词,每条搜索词作为一个文档,保证数据 ID 的唯一性是非常重要的。Elasticsearch 使用文档 ID 来唯一标识每个文档,因此你需要确保每个搜索词都被分配一个唯一的 ID。以下是一些方法来实现这一点:

使用 UUID:

UUID(Universally Unique Identifier)是一种广泛使用的唯一标识符生成方法。你可以为每个搜索词生成一个 UUID,并将其用作文档的 ID。UUID 具有全局唯一性,可以确保即使在不同的系统或时间点上生成的 ID 也不会冲突。1

2

3

4import java.util.UUID;

String uniqueId = UUID.randomUUID().toString();

// 使用uniqueId作为文档的ID基于时间戳和搜索词生成 ID:

如果你的搜索词量不是特别大,并且你希望 ID 具有一定的可读性或者顺序性,你可以考虑使用时间戳和搜索词来生成 ID。例如,你可以将时间戳和搜索词拼接起来,并可能加上一个前缀或后缀来确保唯一性。1

2

3

4

5

6import java.time.Instant;

String timestamp = Instant.now().toString().replace("-", ""); // 移除时间戳中的"-"字符

String searchTerm = "你的搜索词";

String uniqueId = "search-" + timestamp + "-" + searchTerm;

// 使用uniqueId作为文档的ID使用自增 ID:

如果你的搜索词量不是很大,并且你不需要跨多个节点或集群保证唯一性,你可以考虑使用自增的 ID。但是,请注意,如果你有多个节点或者需要扩展集群,自增 ID 可能会导致 ID 冲突。1

2

3AtomicInteger counter = new AtomicInteger(0);

String uniqueId = "search-" + counter.getAndIncrement();

// 使用uniqueId作为文档的ID使用哈希函数:

如果你希望 ID 更短,你可以考虑使用哈希函数(如 MD5 或 SHA-1)对搜索词进行哈希处理,并将结果作为文档的 ID。但请注意,哈希函数可能会产生相同的输出(即哈希碰撞),尽管这种可能性非常低。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18import java.security.MessageDigest;

import java.security.NoSuchAlgorithmException;

String searchTerm = "你的搜索词";

try {

MessageDigest md = MessageDigest.getInstance("MD5");

byte[] hashBytes = md.digest(searchTerm.getBytes());

StringBuilder hexString = new StringBuilder();

for (byte b : hashBytes) {

String hex = Integer.toHexString(0xff & b);

if (hex.length() == 1) hexString.append('0');

hexString.append(hex);

}

String uniqueId = hexString.toString();

// 使用uniqueId作为文档的ID

} catch (NoSuchAlgorithmException e) {

// 处理异常

}

无论你选择哪种方法,都需要确保生成的 ID 在整个 Elasticsearch 集群中是唯一的。如果你使用了多节点集群,并且需要在不同节点之间保证 ID 的唯一性,那么使用 UUID 或基于时间戳和搜索词的方法通常是更好的选择。

异步编程为什么更快

异步编程更快的原因主要有以下几点:

- 非阻塞性:异步编程允许程序在等待某个操作完成时继续执行其他任务,而不是阻塞在那里等待。这样可以避免因等待某个耗时操作而导致整个程序的阻塞,提高了程序的执行效率。

- 并行处理:异步编程可以充分利用多核处理器的优势,将多个任务分配给不同的处理器核心同时执行,从而提高程序的执行速度。

- 减少资源占用:异步编程可以减少程序在等待 I/O 操作(如网络请求、文件读写等)完成时的资源占用,例如内存和 CPU。这样可以让程序在等待这些操作时执行其他任务,提高资源利用率。

- 简化代码逻辑:异步编程可以将复杂的同步代码逻辑转换为更简单、易于理解的异步代码,降低了代码的复杂度和维护成本。

总之,异步编程通过提高程序的执行效率、充分利用多核处理器和减少资源占用等方面的优势,使得程序在处理耗时操作时能够更快地完成任务。

系统性能优化

当然,除了异步编程优化数据插入性能外,还可以考虑以下几种技术上的优化策略来进一步提升系统性能:

- 内存缓存

- 使用缓存库:如 Redis 或 Memcached,将频繁访问的数据(如热门作者或诗词)缓存在内存中,减少对数据库的访问次数。

- 本地缓存:对于单个应用实例,可以使用如 Google 的 Guava Cache 或 EhCache 等本地缓存库,缓存部分数据以减少数据库访问。

- 数据库优化

- 索引优化:确保数据库表的关键字段(如作者、标题等)有适当的索引,以加速查询速度。

- 批量操作:继续利用批量插入操作来减少数据库交互次数,提高数据写入效率。

- 数据库连接池:使用连接池来管理数据库连接,避免频繁地创建和销毁连接,减少资源消耗。

- HTTP 请求优化

- 请求合并:对于多个小的 HTTP 请求,可以考虑合并成一个大的请求,以减少网络延迟和服务器处理时间。

- 请求缓存:对于不经常变动的数据,可以在客户端或代理服务器上缓存 HTTP 响应,避免重复请求。

- 并发控制

- 限流与降级:在并发量过高时,通过限流策略保护核心资源,同时可以采用降级策略,暂时关闭部分功能以保证整体系统的稳定性。

- 解析优化

- 流式解析:使用如 Jsoup 的流式解析功能,避免一次性加载整个 HTML 文档到内存中,减少内存消耗。

- 日志与监控

- 性能监控:通过日志记录和性能监控工具(如 Prometheus, Grafana 等)持续跟踪系统性能,发现瓶颈并进行针对性优化。

- 系统架构优化

- 微服务化:将系统拆分为多个微服务,每个服务负责处理特定的功能,以提高系统的可扩展性和可维护性。

- 负载均衡:使用负载均衡器分发请求到多个应用实例,避免单点故障,提高系统可用性。

- 代码层面优化

- 避免 N+1 查询问题:在数据访问层优化查询逻辑,避免因为不恰当的查询策略导致的过多数据库访问。

- 使用合适的数据结构和算法:确保代码中使用高效的数据结构和算法,减少不必要的计算和资源消耗。

综上所述,通过结合多种优化策略,可以进一步提升系统的整体性能和响应速度。

单体架构升级到分布式架构

从单体架构升级到分布式架构,需要注意以下几个方面:

- 系统拆分:需要对原有的单体系统进行合理的拆分,将其分解为多个可以独立部署和运行的子系统或服务。这一过程中要考虑服务的边界划分,确保每个服务的职责单一,便于管理和维护。

- 数据一致性:在分布式系统中,数据可能会分布在不同的服务或数据库中,因此需要确保数据的一致性。这可能涉及到分布式事务的处理,以及选择合适的一致性模型(如强一致性、最终一致性等)。

- 通信机制:服务之间需要进行通信,需要选择合适的通信机制,如同步调用、异步消息队列等。同时,要考虑到网络延迟、服务可用性等因素,设计容错和重试机制。

- 服务发现与注册:在分布式环境中,服务的位置可能会动态变化,需要实现服务发现和注册机制,以便服务之间能够相互找到并通信。

- 负载均衡:为了提高系统的伸缩性和可用性,需要实现负载均衡机制,使得请求能够均匀地分发到不同的服务实例上。

- 监控与日志:分布式系统的监控和日志记录比单体系统更加复杂。需要有一套完善的监控体系来跟踪系统的性能和健康状况,同时要有集中的日志管理系统,以便于问题的定位和分析。

- 安全性:分布式系统的安全性也是一个重要考虑点。需要确保各个服务之间的通信是安全的,同时还要考虑到服务对外的 API 安全,防止未授权的访问。

- 部署与运维:分布式系统的部署和运维比单体系统更加复杂。需要考虑如何快速部署新版本的服务,以及如何处理服务间的依赖关系。

- 容灾备份:为了保证系统的高可用性,需要设计容灾备份方案,包括数据备份、服务冗余等,确保在出现故障时能够快速恢复。

- 业务改造:从单体架构向分布式架构迁移时,可能需要对现有业务逻辑进行改造,以适应新的架构模式。这可能涉及到代码重构和业务流程的调整。

- 组织文化:分布式架构的引入不仅仅是技术层面的改变,还可能影响到团队的组织文化和工作方式。团队成员需要适应新的开发、部署和运维流程。

- 技术选型:在选择分布式架构的具体实现技术时,需要考虑技术的成熟度、社区支持、学习曲线等因素,选择适合自己团队和业务需求的技术栈。

- 渐进式迁移:如果条件允许,可以考虑采用渐进式迁移的策略,逐步将单体架构中的模块转化为分布式服务,而不是一次性全面转型,这样可以减少风险和压力。

总的来说,从单体架构升级到分布式架构是一个复杂的过程,涉及到系统架构、技术选型、团队协作等多个方面。需要仔细规划和逐步实施,以确保迁移过程的平稳和系统的稳定运行。

CompletableFuture 异步编程

CompletableFuture 是 Java 8 引入的一个功能强大的类,用于异步编程和函数式编程。它提供了一种简单而灵活的方式来处理并发编程中的异步操作和结果。介绍 CompletableFuture 时,可以从以下几个方面入手:

- 基础概念:

- 解释什么是异步编程,为什么在现代应用中需要它。

- 引入

CompletableFuture的概念,并解释其与传统的Future和Callable的区别。

- 创建 CompletableFuture:

- 展示如何使用

CompletableFuture.supplyAsync和CompletableFuture.runAsync创建异步任务。 - 解释这两种方法的参数,如

Supplier和Runnable,并讨论它们的用途。

- 展示如何使用

- 链式编程:

- 展示如何使用

thenApply,thenAccept,thenCompose等方法链接多个异步操作。 - 解释这些方法的返回值类型和作用。

- 展示如何使用

- 异常处理:

- 讨论如何处理

CompletableFuture中的异常。 - 展示如何使用

exceptionally方法处理异常。

- 讨论如何处理

- 组合和合并操作:

- 介绍

allOf,anyOf和completedFuture等方法,用于组合和等待多个CompletableFuture实例。 - 讨论这些方法的使用场景。

- 介绍

- 等待结果:

- 展示如何使用

get和join方法等待异步操作的结果。 - 讨论这两种方法的区别和适用场景。

- 展示如何使用

- 取消操作:

- 解释如何使用

cancel方法取消一个异步操作。 - 讨论取消操作的限制和可能的后果。

- 解释如何使用

- 与其他并发工具的比较:

- 比较

CompletableFuture与其他并发工具(如Future,ExecutorService,RxJava等)的优缺点。

- 比较

- 最佳实践和注意事项:

- 强调避免阻塞等待异步结果的重要性。

- 讨论如何避免创建过多的线程,以及如何优雅地处理异常和取消操作。

- 实际案例:

- 提供一个或多个实际使用

CompletableFuture的案例,以展示其在实际项目中的应用。

- 提供一个或多个实际使用

最后,确保在介绍过程中结合示例代码,以便读者更好地理解和实践所学内容。

API 项目 思考:

设计更多优秀的接口,比如根据用户需求和提交的数据,调用 AI 大模型接口,在线生成图表。对于这种响应时间较长的服务,可以考虑使用异步编程,或者引入消息队列来提高系统响应速度,有效提升系统性能

客户端 SDK 的设计要保持精简,遵循相关规范,保证用户通过 SDK 调用接口服务的简洁性,提升用户体验

切实保障接口调用的性能、稳定性和可用性,可以考虑在网关增加限流和降级保护,以及严格的权限校验机制。给每个用户分配一对密钥,作为调用接口服务的凭证;对每个用户的接口调用次数加以限制;推出充值系统和订单系统,用户可充值购买接口调用次数,以享受接口调用服务

作为一个接口开放平台,目前仅提供了通过客户端 SDK 调用接口服务,应该考虑到如何便捷地添加新的接口服务、如何提高其它开发者接入平台的效率、安全性等,真正地让平台成为开放平台

现在的 客户端 SDK 仅支持下载代码至本地,在本地使用 mvn install 命令打包 SDK,在本地项目中引入 SDK 依赖即可使用

考虑在微服务网关前搭建 Nginx 网关,通过负载均衡实现高并发

多阅读官网文档,Spring Cloud Gateway、Dubbo、Ant Design Pro

你的项目 QPS 是多少?

简单知识复盘

怎么让两个线程轮流执行?使用 wait()和 notify()。一个线程执行完之后调用 notify()唤醒正在等待中的线程,自身调用 wait()进入等待状态。

static 静态变量有什么优势/缺点?节省内存空间,方便访问;数据不一致,难以理解和维护。

UDP 与 TCP 比较。无连接,不可靠,实时性较高,能容忍一定的数据丢失,不保证数据的顺序性完整性,没有序列号、确认机制、超市重传、流量控制、拥塞控制。

为什么选择 Redis?Redis 是单独的中间件,不同客户端把 session 存放在 redis 上,实现在分布式结构中的资源可见性,解决用户登录失效问题;Redis 单线程,支持 lua 脚本,保证了并发操作安全的同时,能很好地实现分布式锁;作为缓存数据库,存储热门数据,减轻数据库压力。

项目的开发流程:参考已有的产品学习了解,总结比较好的功能点。结合自己扩展的功能特色,做整体设计,经过需求分析后得到产品原型。选用合适的技术,解决具体的业务问题。

为什么使用 Dubbo RPC?首先为了减小网关模块的体量,避免引入复杂的业务逻辑,保证设计模式遵循的单一原则,决定使用 RPC 实现服务间调用。OpenFeign 的方式也考虑过,本质上是构建 HTTP 请求,发送请求去调用对外提供的服务。这种方式需要添加很多请求头,使用 JSON 序列化的效率也不高,更加适合外部服务。选用 Dubbo,基于 TCP 协议,避免无用的请求头,序列化为二进制流传输,效率高。